Amazonのアソシエイトとして、当ブログは適格販売により収入を得ています。

以前、Intel ARC B570でllama.cppを使う記事を書きました。

現在はどうかわかりませんが、当時はIntel ARC のハードウェアアクセラレーションを使ってLMStudioを使うことができませんでした。

Vulkan.APIはあるみたいなのですが、うまくARCを認識しないようで・・・。

なので、あえてLMStudioには触れないでいたのですが、RadeonならROCmで動くみたいなので今回記事にしてみます。

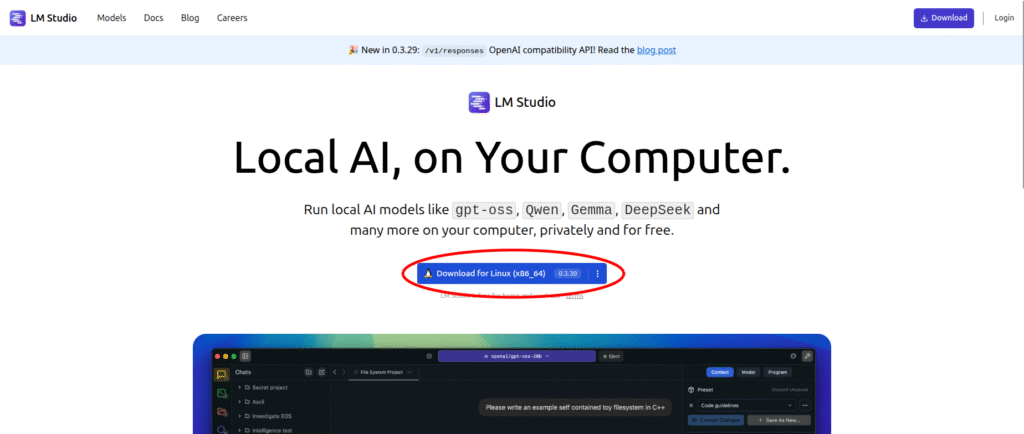

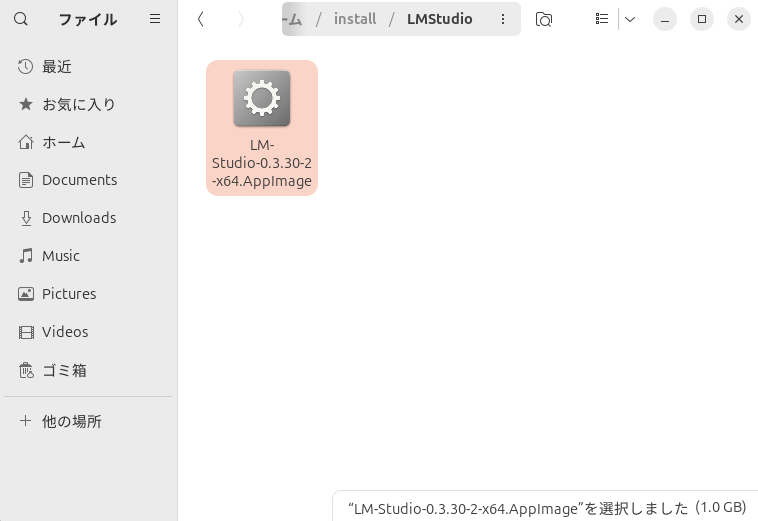

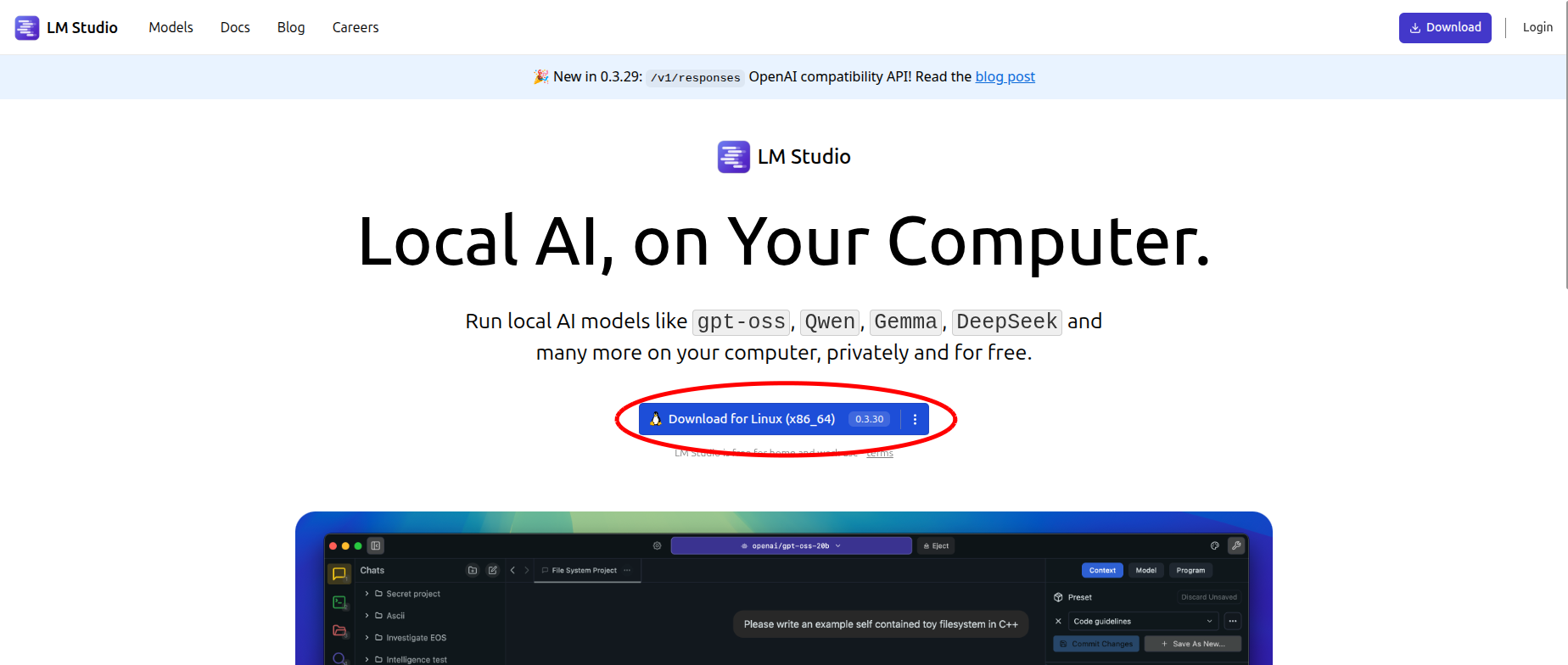

LMStudioをダウンロード

実行してみよう

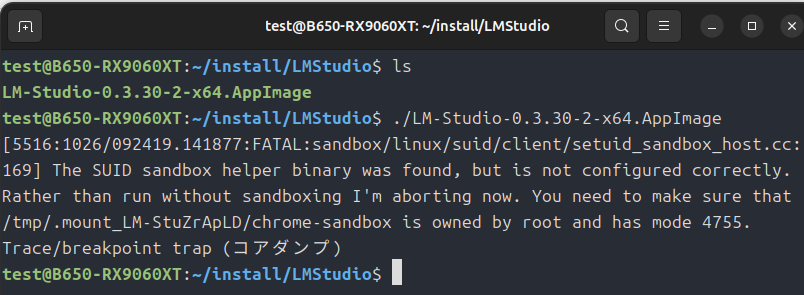

sudo chmod +x ./LM-Studio-0.3.30-2-x64.AppImage

./LM-Studio-0.3.30-2-x64.AppImageで実行権限を与えて「./LM-Studio-0.3.30-2-x64.AppImage」で動かそうとしたのですが、ここで問題発生。

./LM-Studio-0.3.26-6-x64.AppImage --no-sandboxChatGPTに相談したところ、このコマンドで動くようにはなりますが、セキュリティ上よろしくないとのことです。

ではどうするのかというと、一度appimageを展開して「chrome-sandbox」の実行権限を変更すればセキュリティ上も問題なく動くらしいです。

# 展開(カレントに squashfs-root/ ができます)

./LM-Studio-0.3.26-6-x64.AppImage --appimage-extract

cd squashfs-root

sudo chown root:root chrome-sandbox

sudo chmod 4755 chrome-sandbox

# 展開版を起動

./AppRun

#または

./lm-studio以上で動作するようになります。

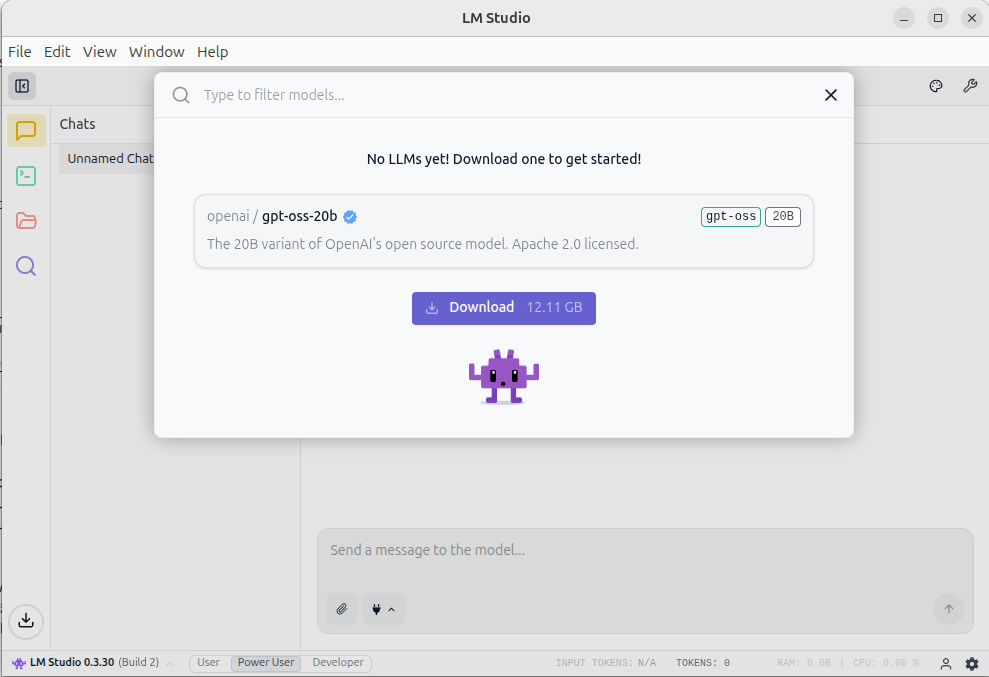

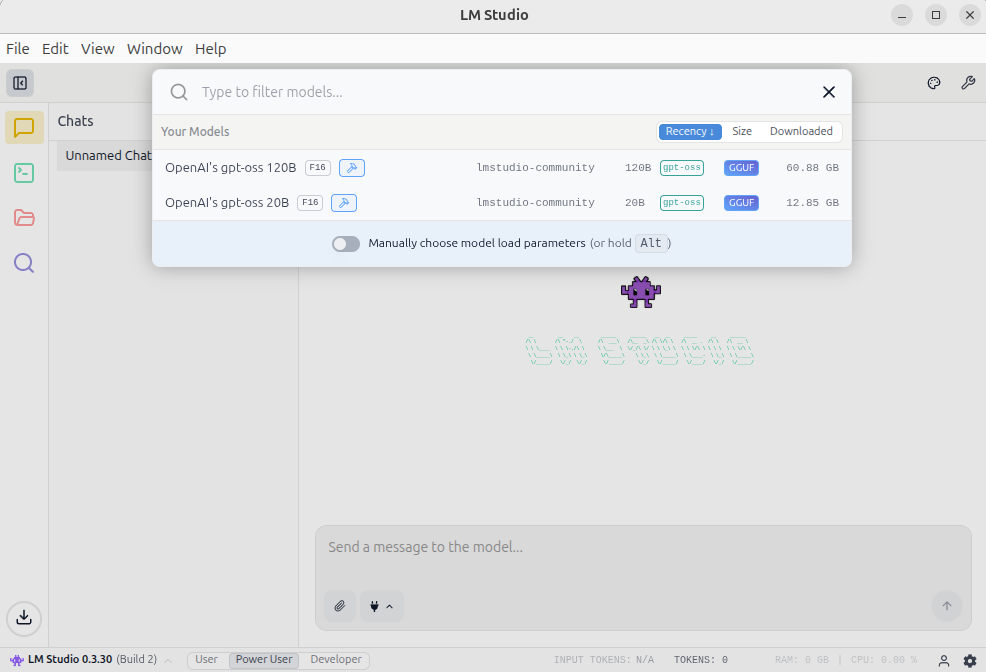

モデルファイルの準備

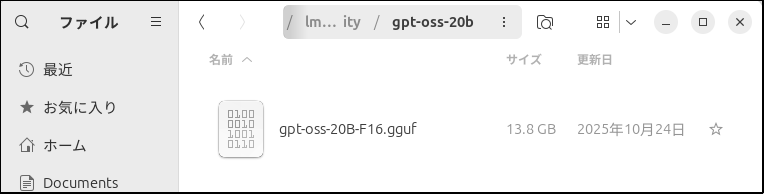

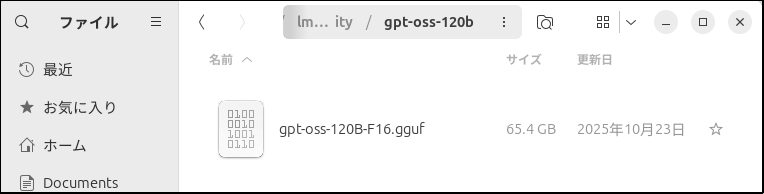

gpt-oss-20bは動かすには手頃なのでダウンロードしてみるのも良いと思いますが、以前の記事でllama.cpp用にダウンロードしてggufに変換したファイルがあるのでそちらを再利用します。

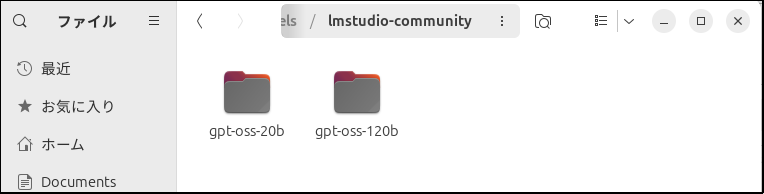

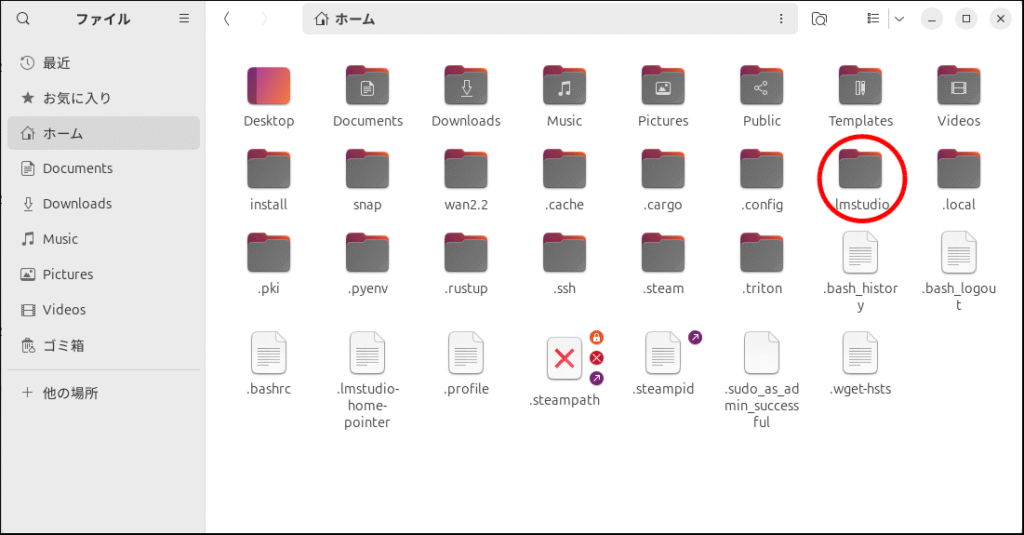

さてこれらファイルをどこに置けば良いのかというと、

/home/test/.lmstudio/models/lmstudio-community上のアドレスの「lmstudio-community」の下に

「/home/test」は私のPCの環境のフォルダ名です。

みなさんはそれぞれの環境に合わせて変更して読んでください。

注意点ですが、「.lmstudio」は隠しファイルになっていますので、

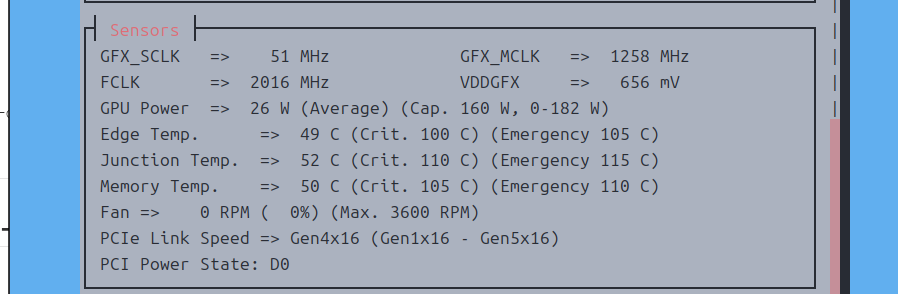

設定を詰めても良いでしょうが、今回はそのまま「120b」を使います。

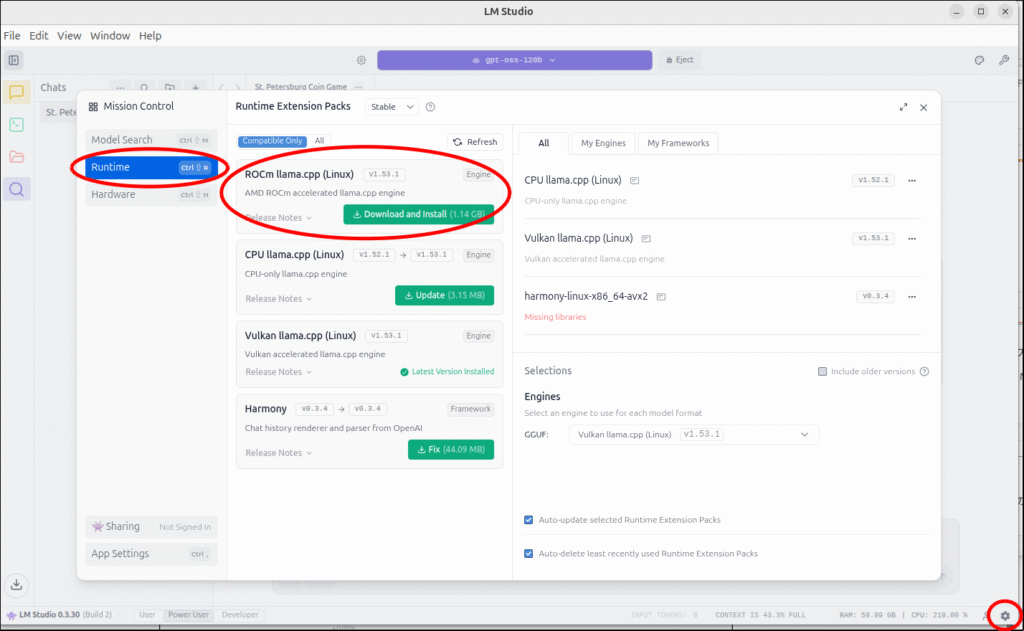

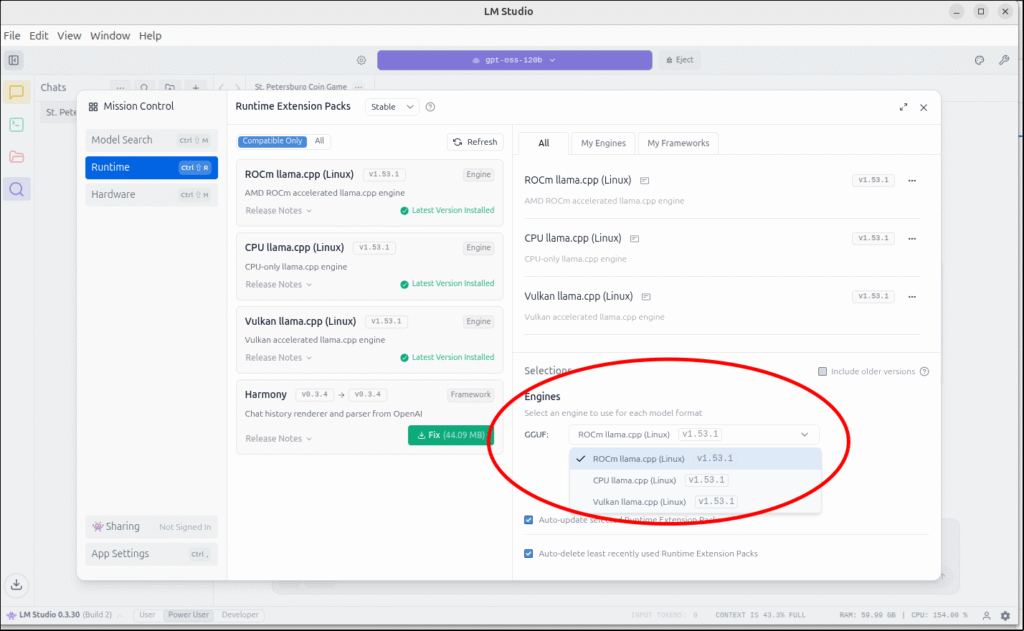

ROCm llama.cpp(Linux)を準備

では、いよいよ動作テスト

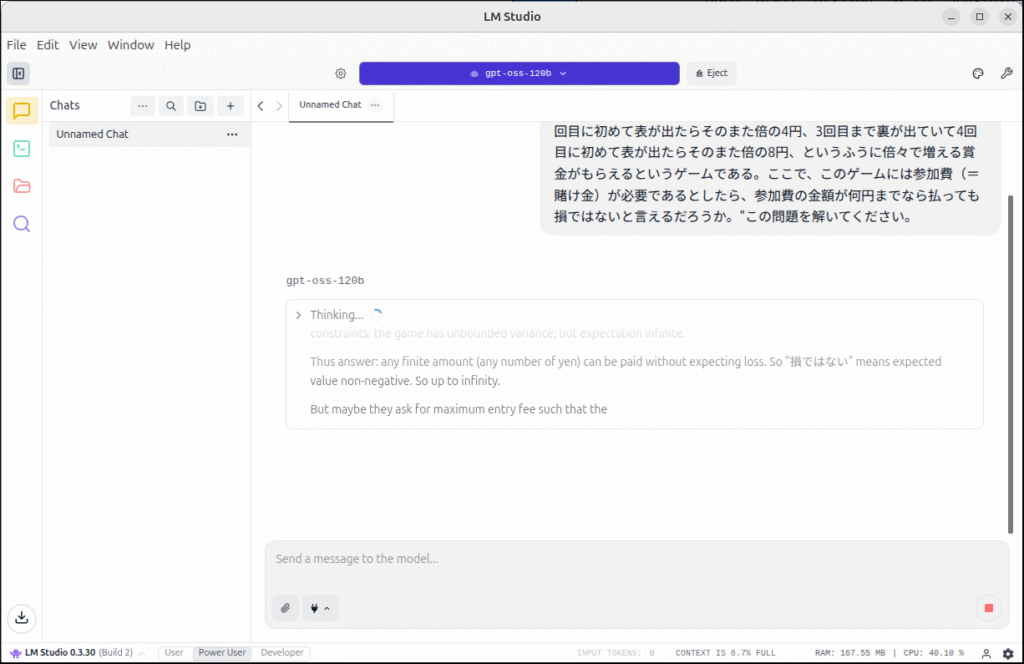

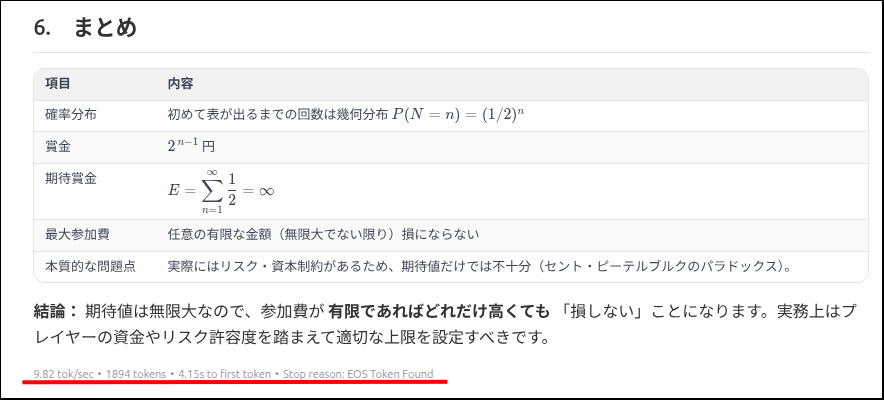

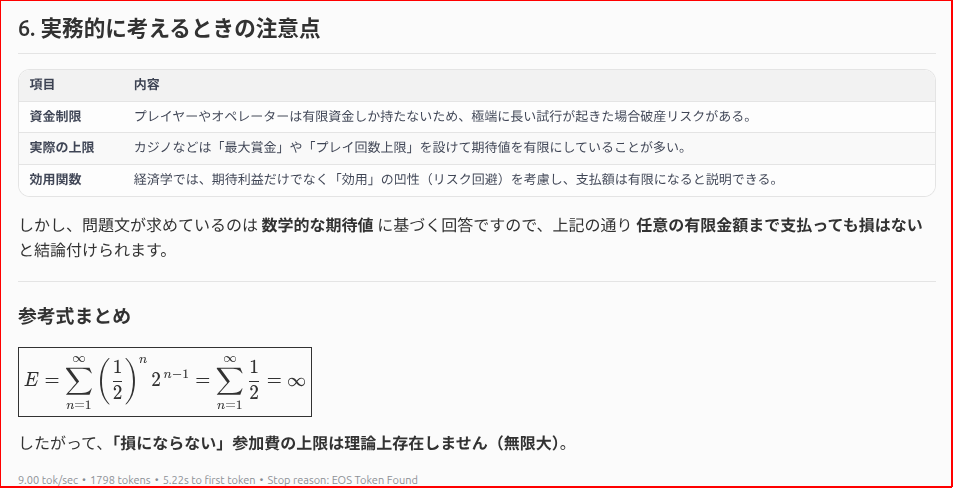

"偏りのないコインを表が出るまで投げ続け、表が出たときに、賞金をもらえるゲームがあるとする。もらえる賞金は、1回目に表が出たら1円、1回目は裏が出て2回目に表が出たら倍の2円、2回目まで裏が出ていて3回目に初めて表が出たらそのまた倍の4円、3回目まで裏が出ていて4回目に初めて表が出たらそのまた倍の8円、というふうに倍々で増える賞金がもらえるというゲームである。ここで、このゲームには参加費(=賭け金)が必要であるとしたら、参加費の金額が何円までなら払っても損ではないと言えるだろうか。"この問題を解いてください。例のサンクトペテルスブルクのパラドックスでいきましょう。

以前の記事で書き忘れていたのですが、このネタは

上記リンクの「Ubuntu日和(あわしろいくや氏)」の記事を参考にしています。

とりあえず、動作確認はとれました。

設定を詰めたら早くなるんでしょうか。

いつも使っているChatGPTですが、あまり公開したくない情報を取り扱う時なんかは、LMStudioを使うのも手かもしれませんね。

とはいえ、gpt-ossは「オープンソースモデルとしては優秀だが、トップ商用モデルと並ぶというわけではなく、“中位~やや上位”の位置付け」という評価もあるみたいなので、ChatGPTの代わりになるかというと、「日常会話・カスタムチャットボット用途」であれば・・・、といったところなのかもしれません。

今回は以上です。

追記

コメント