Amazonのアソシエイトとして、当ブログは適格販売により収入を得ています。

前回はこちらの記事で、GPT-SoVITS-For-Intelの「GPTトレーニング」と「SoVITSトレーニング」を使ってIntel Arcで学習モデルを作ってみました。

ただ、これらを行うのにIPEX(Intel Extension for PyTorch)を使っていました。

知っている方もおられると思いますが、IPEXは「Intel® Extension for PyTorch* will reach end of life (EOL) by the end of March 2026. 」と公式の発表もありますとおり、オワコンとなります。

そこで、どこまで意味があるかわかりませんが「GPT-SoVITS-For-Intel」がtorch.xpuで動くように、今回いじりたおしてみました。

その過程で処理の高速化という副産物もありましたので、興味のある方は見ていってください。

それでは、いってみましょう。

副産物

まぁ、副産物というか、ついでに見直した部分があったので。

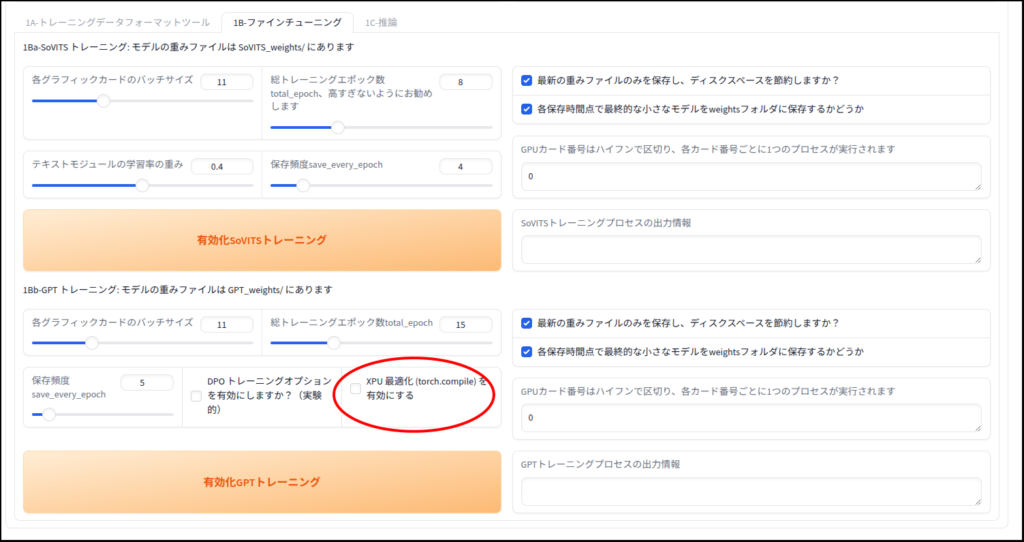

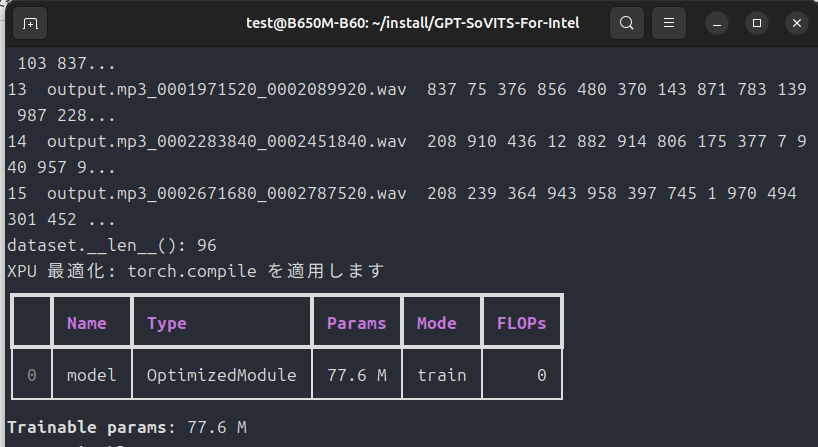

- 「GPTトレーニング」時に「torch.compile」を導入(意味があるかは不明)

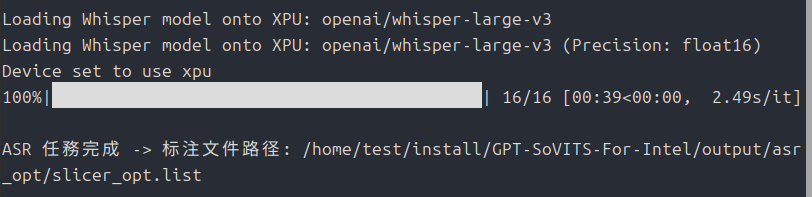

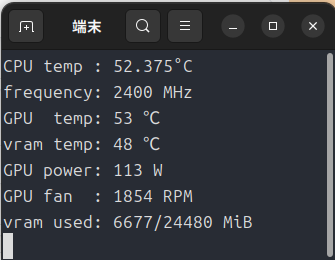

- 1〜2分の学習元音声ファイルの文字起こしを「Intel Arc」で処理できるように変更

この2点です。

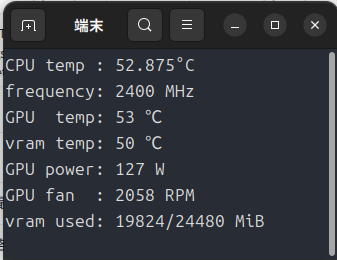

特に文字起こしはCPU処理からxpu処理に代わったことで随分高速化しました。

高速化の代償

インストールがちょっと(?)めんどくなってしまいました。

以下、GPT-SoVITS-For-Intel本体のインストールスクリプトです。

追記(2026/1/27)

transformersのバージョンが5.0.0になってから、依存関係が保てなくなっていたようです。

transformers==4.57.3に書き換えることで、動作することを確認しました。

以下のスクリプトは書き換え済みです。

#!/bin/bash

#インストールに必要なライブラリ等をインストール

sudo apt update

sudo apt install git

sudo apt install curl

sudo apt install build-essential cmake

# uvをcurlでインストール

curl -LsSf https://astral.sh/uv/install.sh | sh

source $HOME/.local/bin/env

#GPT-SoVITS-For-Intelのインストール

cd ~

mkdir -p install

cd install

git clone https://github.com/IzayoiSakuya16/GPT-SoVITS-For-Intel.git

cd GPT-SoVITS-For-Intel

#uvでpython3.12環境を作る

uv venv --python 3.12 --seed

# uv環境を有効化

source .venv/bin/activate

#torch.xpuをインストール

#stable

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/xpu

#音声データの文字起こしに「insanely-fast-whisper」を使います

#transformersのバージョンを指定し直しました

uv pip install transformers==4.57.3 accelerate

# 「GPT-SoVITS-For-Intel」のrequirements.txtを実行

uv pip install -r requirements.txt

#triton関係を一度削除

uv pip uninstall triton triton-xpu pytorch-triton-xpu

# pytorch-triton-xpu を明示的にインストール

uv pip install pytorch-triton-xpu --index-url https://download.pytorch.org/whl/xpu

#モデルファイルのダウンロードと配置(git-lfs)

sudo apt install git-lfs

git lfs install

cd ~/install/GPT-SoVITS-For-Intel/GPT_SoVITS/pretrained_models/

git clone https://huggingface.co/lj1995/GPT-SoVITS

cp -r GPT-SoVITS/* .

#configファイルの配置(「GPT-SoVITS-For-Intel」には何故かこれらのファイルが存在しませんので、本家から拝借しています)

cd ~/install/GPT-SoVITS-For-Intel/GPT_SoVITS/configs/

git clone https://github.com/RVC-Boss/GPT-SoVITS.git

cd GPT-SoVITS/GPT_SoVITS

cp -r configs/* ~/install/GPT-SoVITS-For-Intel/GPT_SoVITS/configs/

cd ~/install//GPT-SoVITS-For-Intel次はいろいろとソースコードをいじってしまったので、変更のあったファイルをリスト化します。

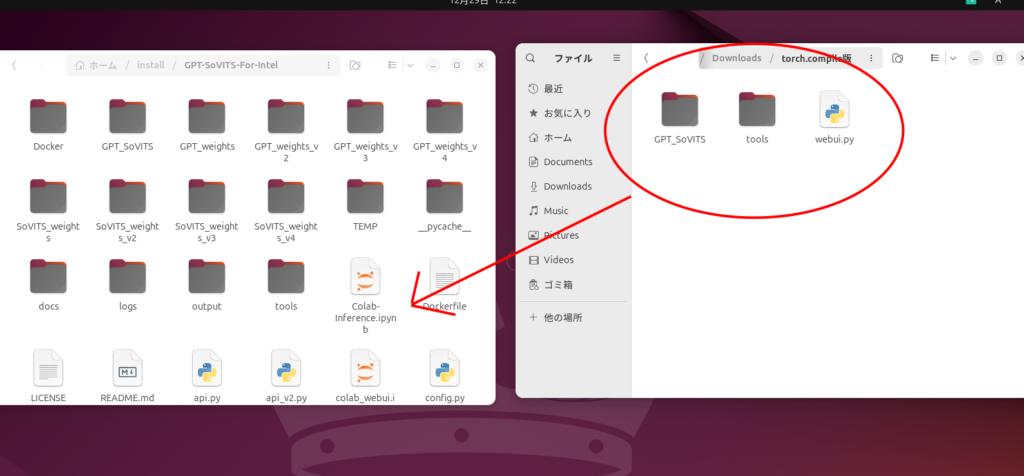

- GPT-SoVITS-For-Intel/webui.py

- GPT-SoVITS-For-Intel//GPT_SoVITS/inference_webui.py

- GPT-SoVITS-For-Intel//GPT_SoVITS/s1_train.py

- GPT-SoVITS-For-Intel//GPT_SoVITS/s2_train.py

- GPT-SoVITS-For-Intel/GPT_SoVITS/AR/models/t2s_lightning_module.py

- GPT-SoVITS-For-Intel/tools/asr/whisper_asr_xpu.py

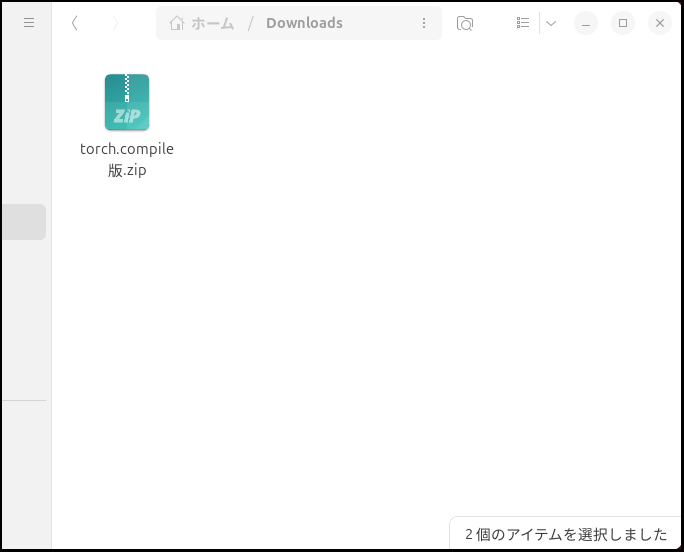

それぞれのスクリプトを載せようと思ったんですが、あまりに長いため、megaアップローダ上に置いておきます。ダウンロード後は解凍してそれぞれのディレクトリに置いて上書きしてください。

ダウンロードしたら、

後はターミナル(端末)を起動して

source .venv/bin/activate

python ./webui.pyで起動です。

動作確認

基本的な操作がまだわからない人は、こちらの以前の記事を参考にしてください。

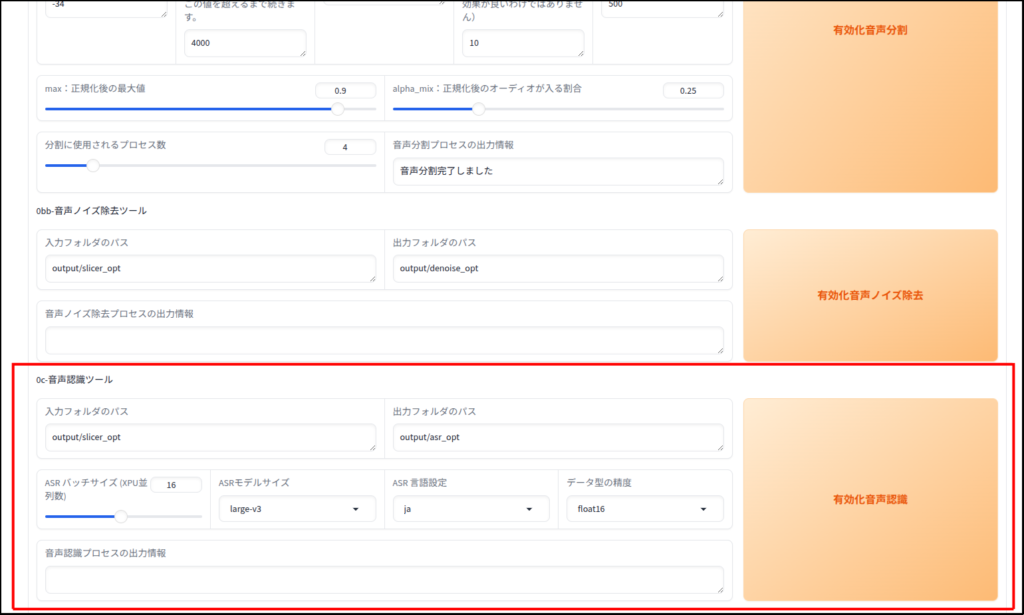

まずひとつ目の変更点

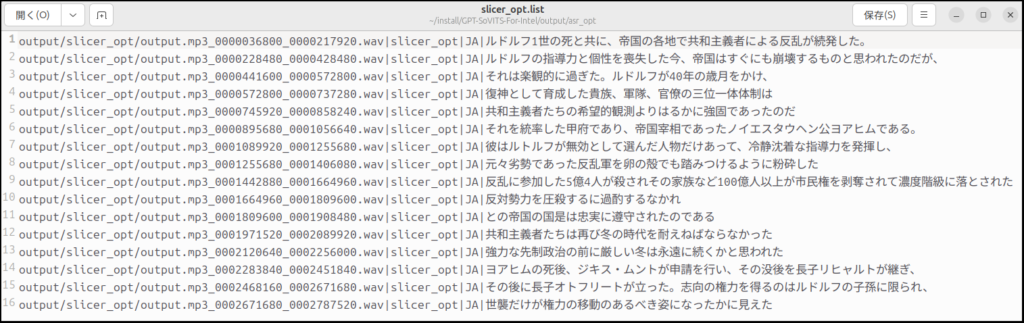

文字起こしは「faster_whisper」ではなく「insanely-fast-whisper」に変更しています。

「faster_whisper」はcuda用でxpuではどうやっても動きませんので使用を断念しました。

- バッチサイズはVRAMをどれだけ使うかという設定です(通常はそのままでOK)。

- モデルサイズは「large-v3」が一番大きく一番精度が高いです(一番遅いけど)。

- 言語設定は「ja」は「1〜2分の素材の音声」の言語設定です。

- データ型は一応指定できますが、特段理由が無いなら「float16」のままで。

データ型は今後のtorch.xpuの発展に合わせて他のデータ型に対応していくと思いますが、現在は実質「float16」と「float32」のみです。「int8」も動きません(float32にフォールバックされます)。

「fp8」はそもそもBattlemageはハードウェアで対応していません。

好きに変えてみてください。

次は「GPTトレーニング」です。

といっても、速度差はありませんので、使ってみたい人はチェックを入れてみてください。

音声の出来栄えは?

あんま変わらないといったところ。

今回の変更で一番恩恵があったのは、音声ファイルからの文字起こしの高速化のみですね。

個人的にはこれだけでもかなり速くなったので満足はしています。

最後に

AI用途はcuda一強が続いていますが、pytorchのおかげでオープンソースソフトウェアであれば、チャットAIなどを利用して、Intel Arcでも動作できるところまではもっていけます。

便利かと言われればそんなことはありませんが、今はこの不便さを楽しみたいと思っています。

今回は以上です。

自分が使っている「Pro B60」ですが、記事を書いている現在は在庫が全滅しています。

価格.comでも全て空ですね。

こんな高価なのは、無理に買わなくても下のB580の方が個人的にオススメです。

B580は玄人志向のDFが安く、全長240mmと小さいので取り回しも良くオススメです。

負荷中はちょっとうるさいかもしれませんが、B60よりははるかにマシでしょう。

2025/12/29現在

グラフィックスカードの価格がじわじわと上がってきているようですね。

メインメモリはみなさんが知っている通り絶望的な価格上昇となっています。

今後SSDやHDD、グラフィックスカードも上がっていくでしょう。

6〜8万円がポンと出せるならRadeonやGeForceも良いでしょうが、そうでないならまだギリ3万円台で買える「Arc B580」はオススメです。

まぁ、B580も値上げが始まっているようですが・・・。

コメント