前回の記事でllama.cppをROCmでビルドしてRX9060XT(16GB)で動かすという内容の記事を書きました。

ただ、この方法ではPolaris世代(RX400、RX500シリーズ)や、GCN(RX VEGAシリーズ)、RDNA(RX5000シリーズ)は動作させられません(現在のROCm非対応)。

ですが、vulkanなら動作させられます。

家にある7年前に組み上げたPC(Ryzen5 2600X,RX470 8GB,32GBメモリ)でllama.cppを動かそうとした時にROCmで動作しなかったことから気づきました。

では、やっていきましょう。

llama.cppをvulkanでビルドする

カレントディレクトリを「llama.cpp」に移動します。

sudo apt install libvulkan-dev glslc

cmake -B build-vulkan -DGGML_VULKAN=ON

cmake --build build-vulkan --config Release -j$(nproc)以上で、ビルドできるでしょう。

フォルダ名は「build-vulkan」になっていると思います。

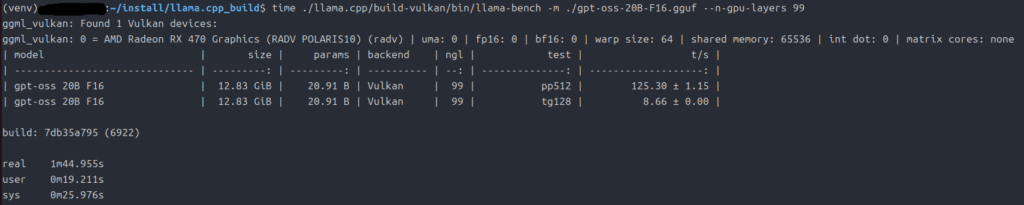

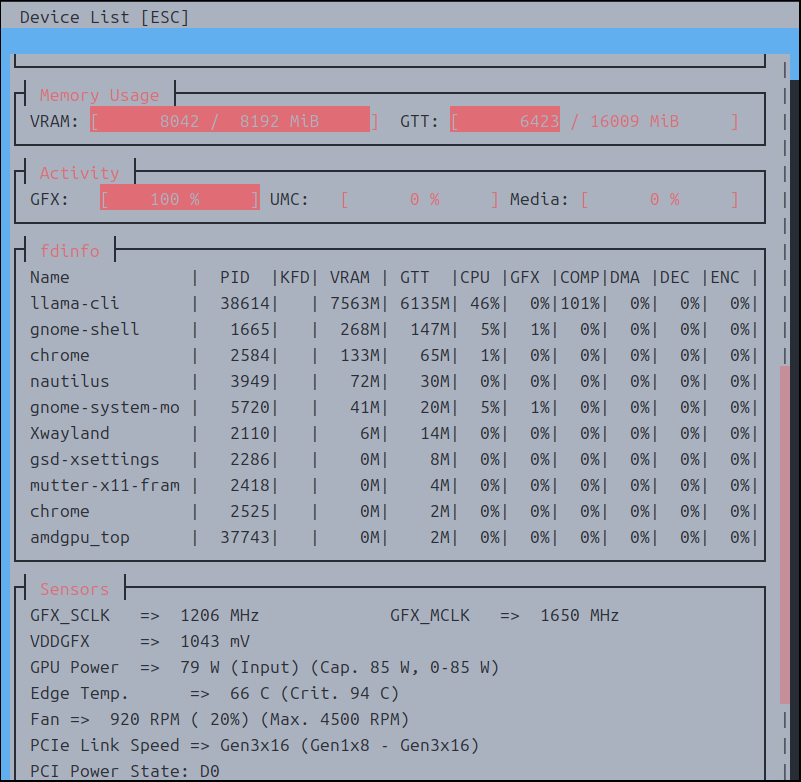

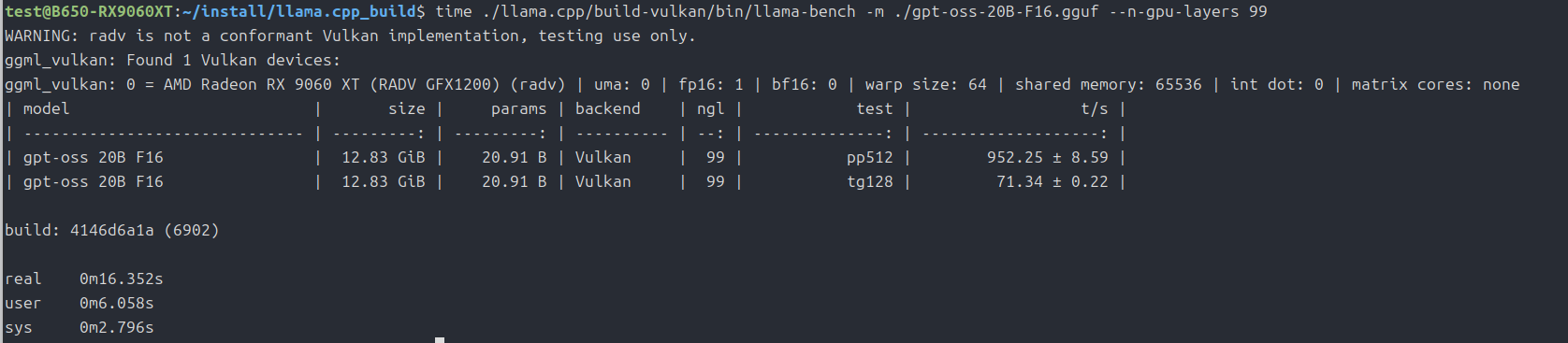

RX470(8GB)でベンチマーク(gpt-oss-20bのみ)

time ./llama.cpp/build-vulkan/bin/llama-bench -m ./gpt-oss-20B-F16.gguf --n-gpu-layers 99上記はllama.cpp(vulkan動作)のコマンドです。

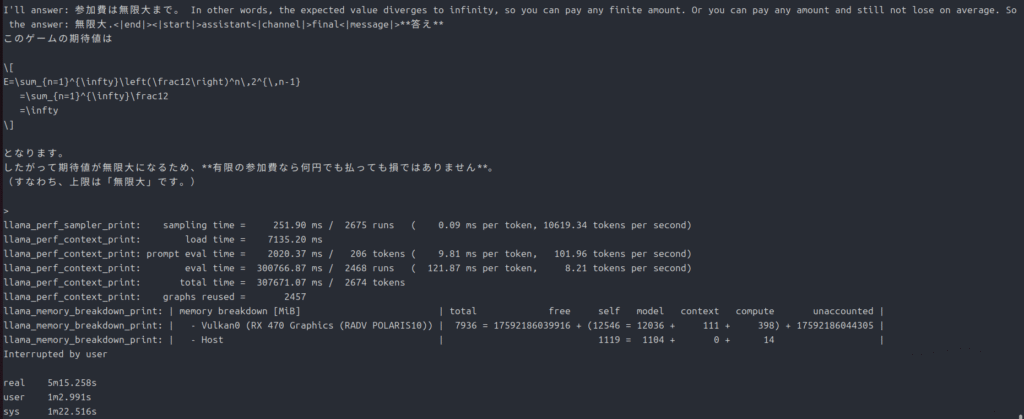

ちなみにいつものパラドックスの問題の方は、

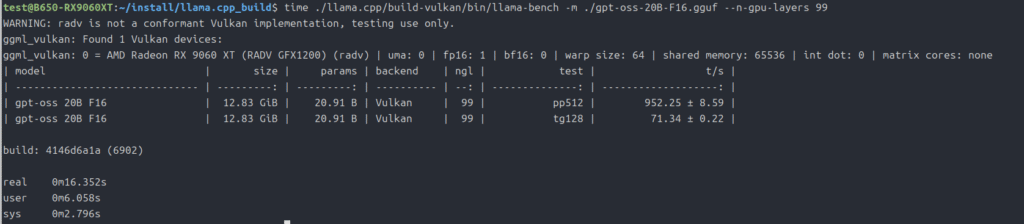

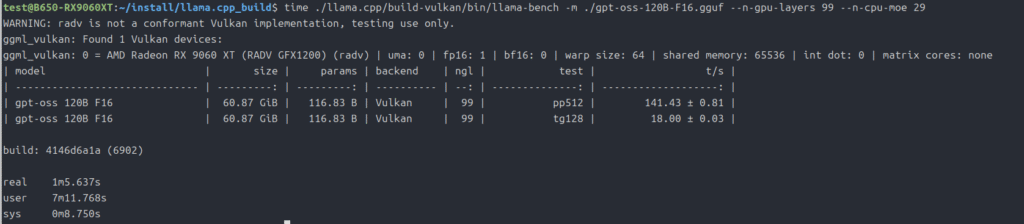

ついでにvulkan動作をRX9060XT(16GB)で

ROCmはまだ起動オプションをいろいろ試していない状態なので、まだ伸びしろがあるかもしれませんが、vulkanはそのままでも速いですね。

最後に

もし、Polaris世代(RX400、RX500シリーズ)や、GCN(RX VEGAシリーズ)、RDNA(RX5000シリーズ)を使っているLinuxユーザーがいたら是非試してみてください。

vulkanなのでWindowsでも動くでしょうが、ビルドの環境の作り方を自分は知らないもので、記事にできません。

今回は以上です。

コメント