Amazonのアソシエイトとして、当ブログは適格販売により収入を得ています。

せっかくGPUを新しくしても、基準となるベンチマークテストが今まで無かったため、イマイチ性能差の比較が難しかったので、独自にベンチマークのワークフローを作ってみることにしました。

といってもそんな難しくないです。

テンプレートをベースにちょっとだけ変更を加えただけです。

wan2.2を使っています。

今回の記事は、作ったワークフローの動作テストになります。

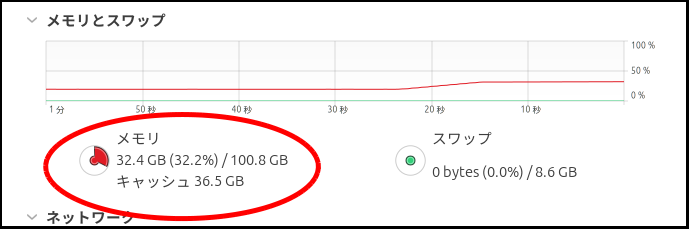

更に、2025/12/6時点でメインメモリの価格が急激に高騰しています。

安直に買い足せる状況ではなくなっているため、できるだけメインメモリの消費量を抑えるためGGUFモデルを使っています。

このワークフローなら、GeForceだろうが、Radeonだろうが、Arcだろうが普通に動きます。

VRAMが少ないGPUを使っている人たちの味方「–novram」も使えます。

但し、sageattentionとか入れると特定のGPUだけ速くなって比較がめんどくなるのでそういったものは無しです。

追記

2025/12/4の時点でRadeonで「–novram」を使うと高確率でHIPのメモリアクセスエラーが起こるようです。

以前、この記事を書いた時にはこのようなことは全く起こらなかったのですが、最近のアップデートの影響でしょうか?

ちょっとよくわかりません。

それではいってみましょう。

ConfyUIとカスタムノードのインストール

ComfyUIのインストール方法は「Arc版」はこの記事で紹介していますが、最近はtorch.xpuの方がメモリ使用量も少なくオススメなので、そちらの方法を書いておきます。

sudo apt update

sudo apt install git

sudo apt install git python3 python3-pip python3-venv

sudo apt install -y libgoogle-perftools-dev

cd ~

mkdir -p install

cd install

#comfyuiのインストール

git clone https://github.com/comfyanonymous/ComfyUI.git

cd ComfyUI

#仮想環境の構築

python3 -m venv venv

source ./venv/bin/activate

#pytorchのインストール

#nightly

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/nightly/xpu

#stable

#pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/xpu

#cliploaderggufで必要

pip install protobuf

#pipのアップグレード

pip install --upgrade pip

#環境を整える

pip install -r requirements.txttorch.xpuはnightlyを使っています。

stableが良いという人はコメントアウトを書き換えて下さい。

Radeonの方はこちらの記事を参考にして下さい。

但し、2025/12/4の時点では「–novram」は頻繁にメモリアクセスエラーが起こります。

直るまでVRAMオプションは付けない方が良いでしょう。

今回自分で作ったベンチマーク用ワークフローに必要なカスタムノードは以下のとおりだったのでスクリプトにしてみました。

cd ~/install/ComfyUI

#ComfyUI-Manager

git clone https://github.com/ltdrdata/ComfyUI-Manager.git

#VideoHelperSuite

git clone https://github.com/Kosinkadink/ComfyUI-VideoHelperSuite.git

#calcuis/gguf

git clone https://github.com/calcuis/gguf.git

cd ../

source ./venv/bin/activate

#requirements.txtインストール

#ComfyUI-Manager

python3 -s -m pip install -r ./custom_nodes/ComfyUI-Manager/requirements.txt

#VideoHelperSuite

python3 -s -m pip install -r ./custom_nodes/ComfyUI-VideoHelperSuite/requirements.txt

#ComfyUI起動

python main.py --auto-launch --novramこれでインストールが済んだ後、ComfyUIが起動すると思います。

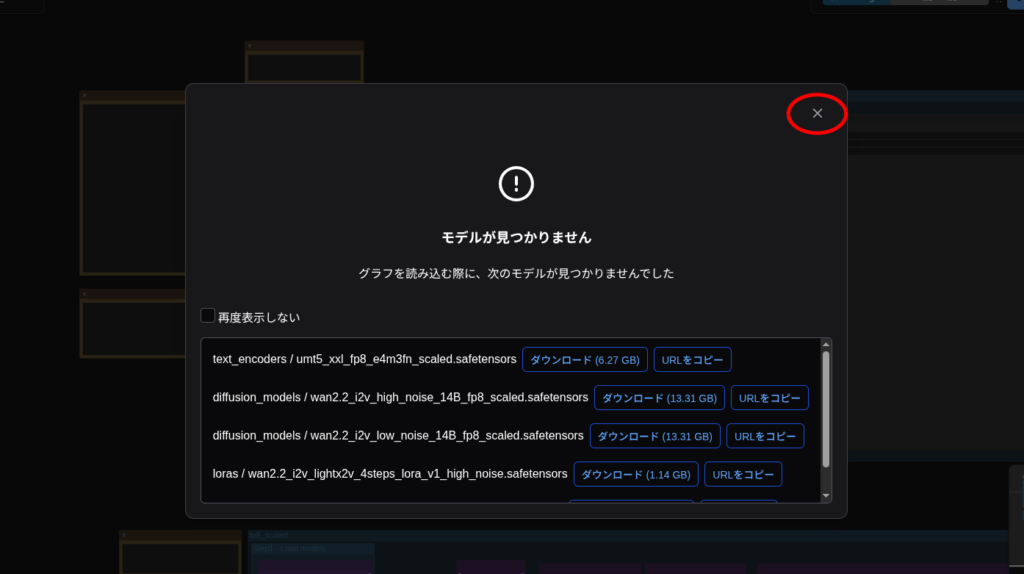

必要なモデルファイルをダウンロード

今回のワークフローで必要なモデルファイルをダウンロードしてきましょう。

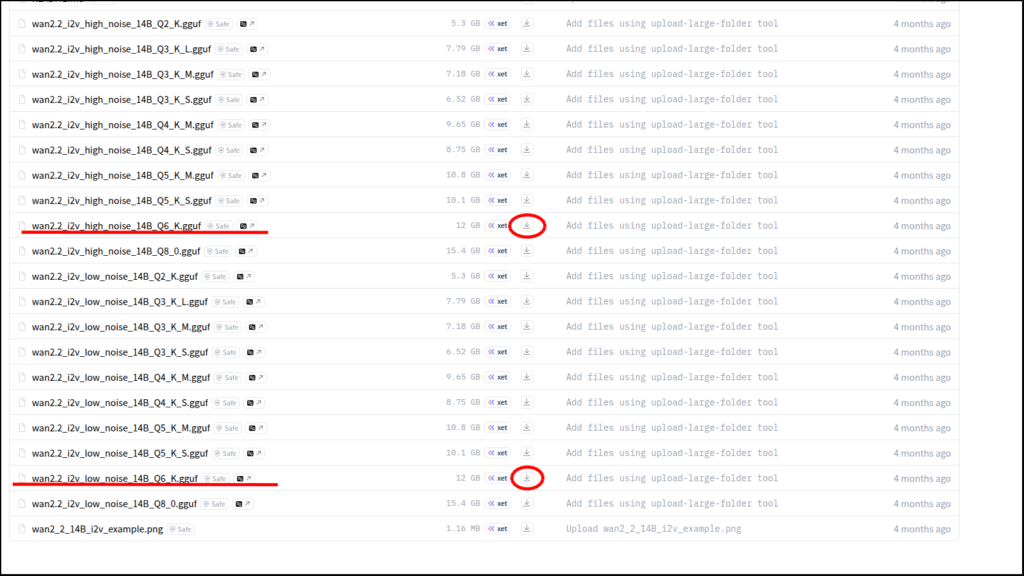

まずは「diffusion_models」です。

上のリンクに移動したら、

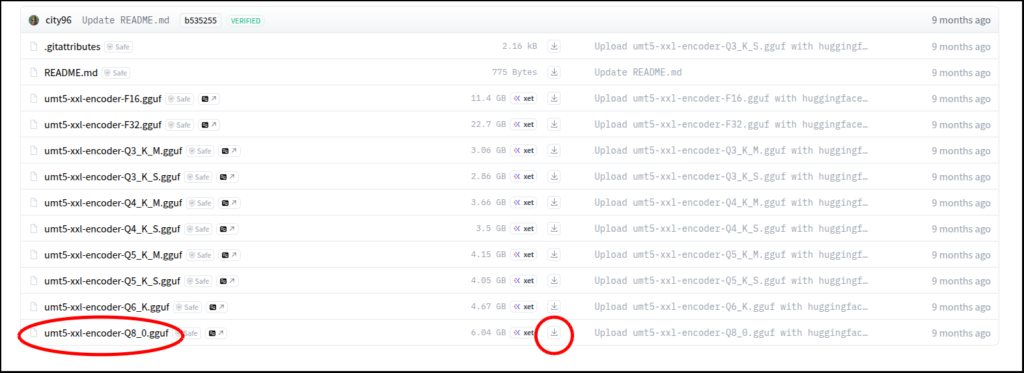

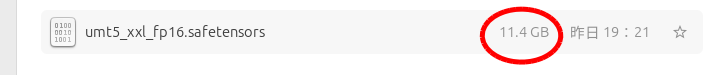

次はテキストエンコーダです。

上のリンクに移動したら、

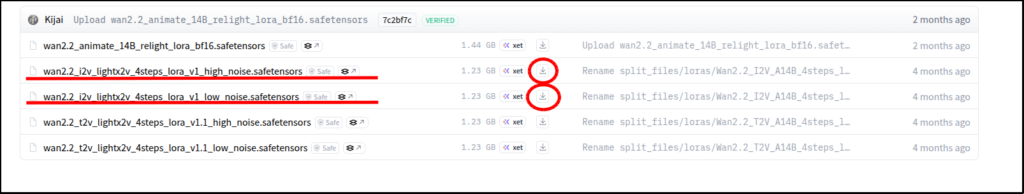

次はloraです。

上のリンクに移動したら、

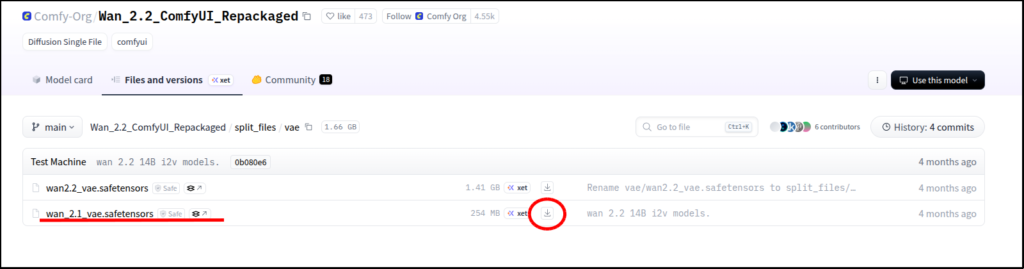

最後にVAEです。

上のリンクに移動したら、

以上でモデルファイルの用意は終わりです。

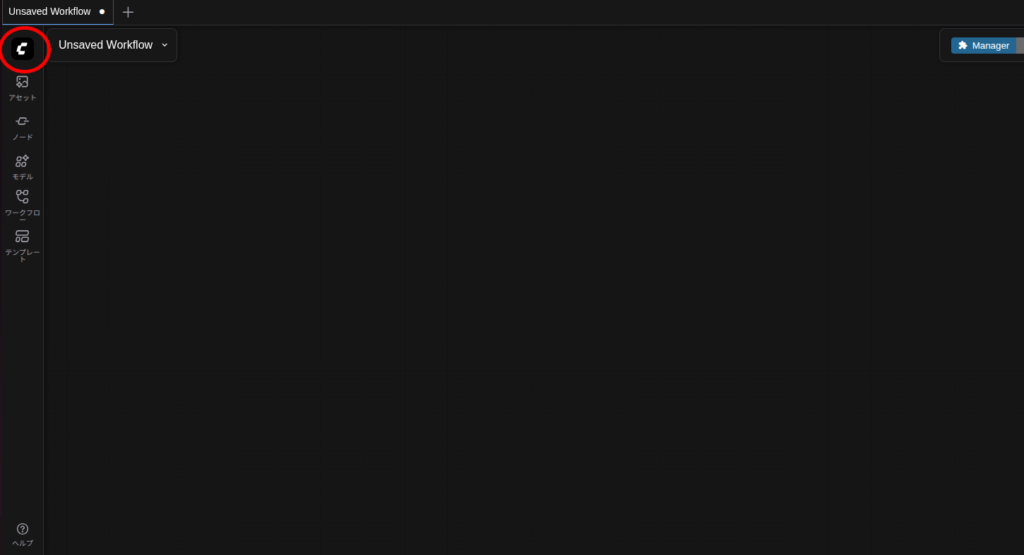

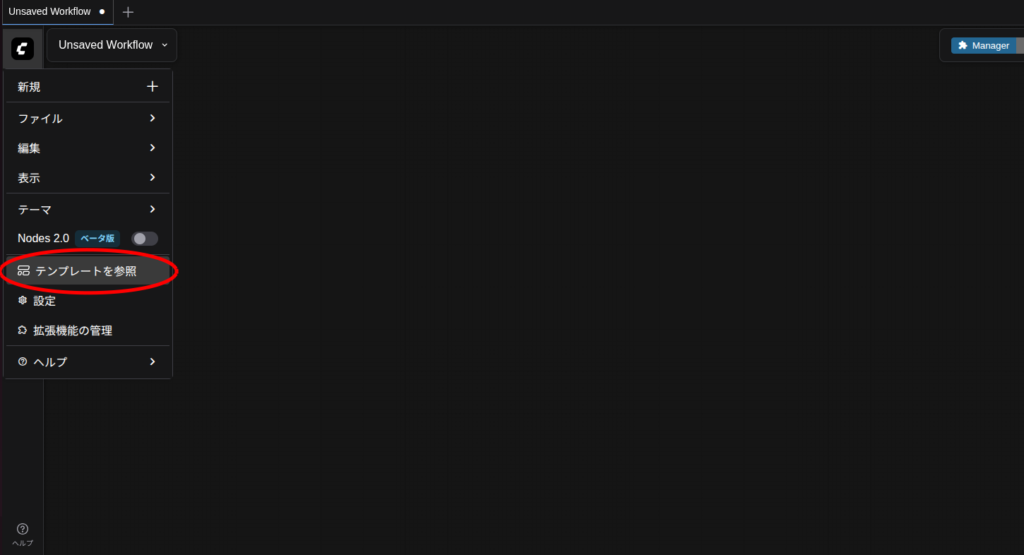

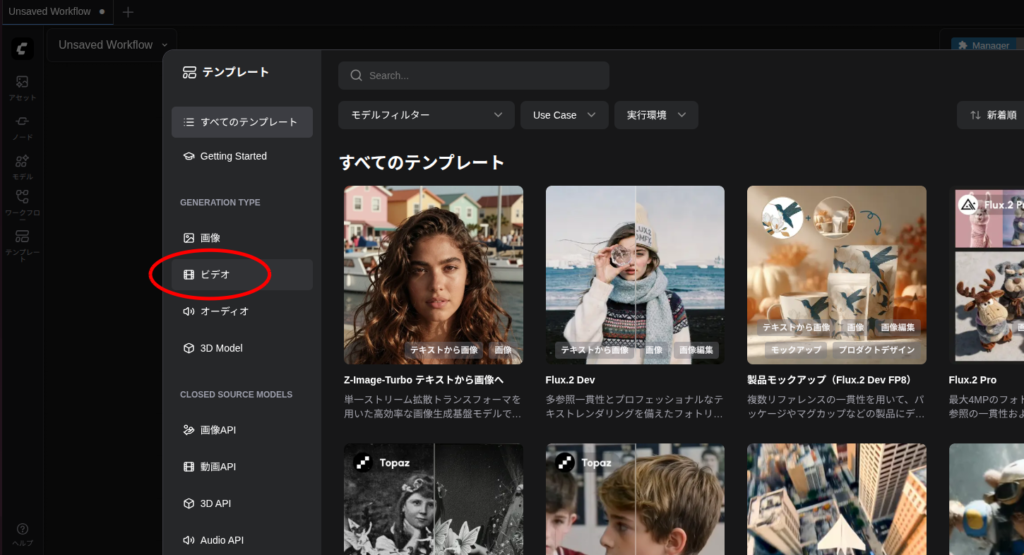

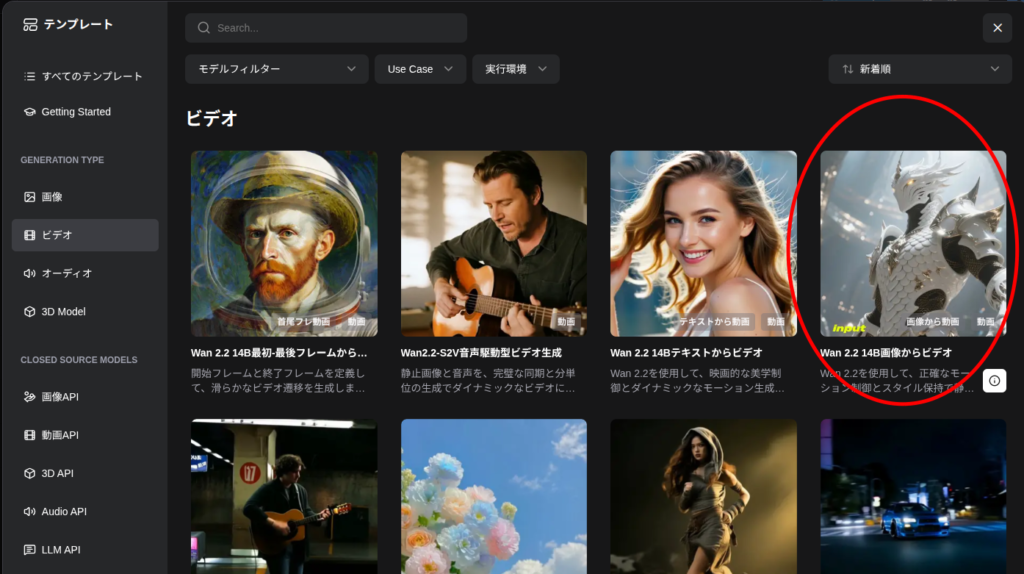

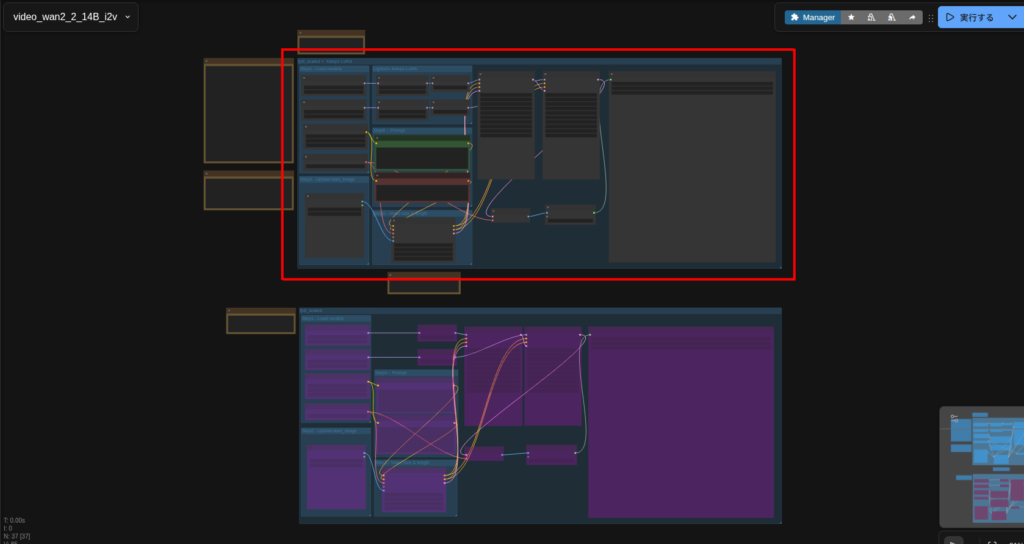

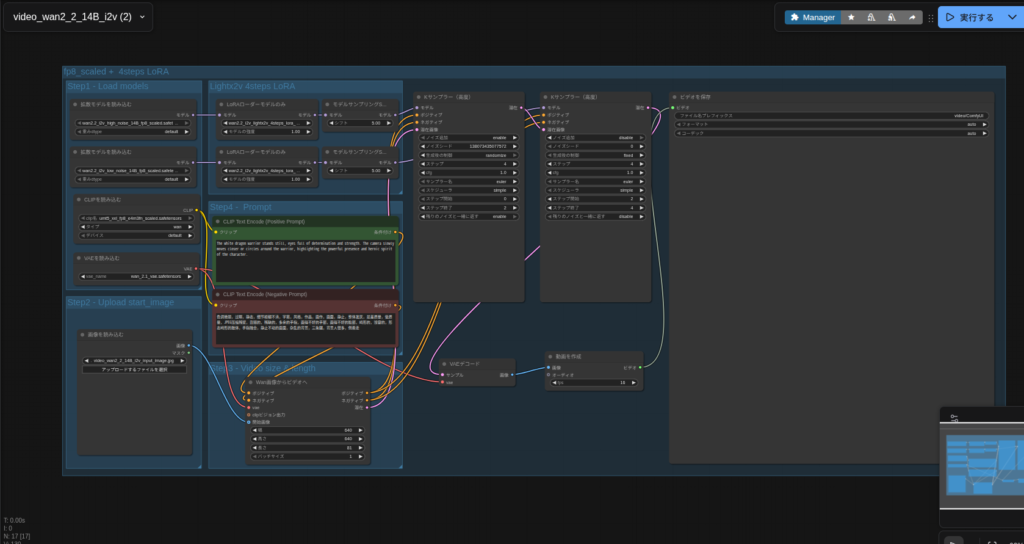

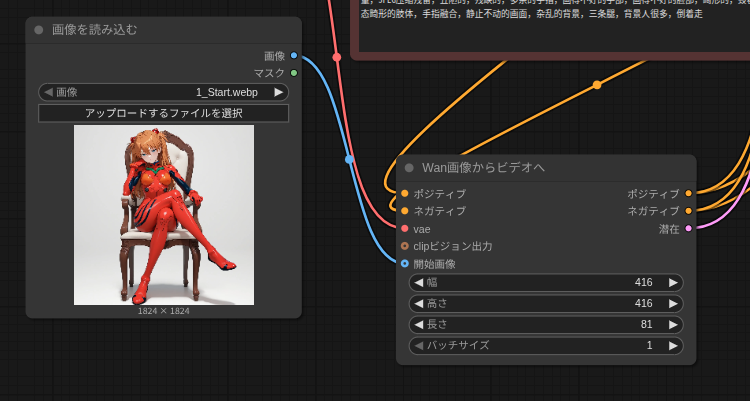

テンプレートのワークフローをいじっていこう

ワークフローをつくっていきますが、ベースとなるのはComfyUIのテンプレートです。

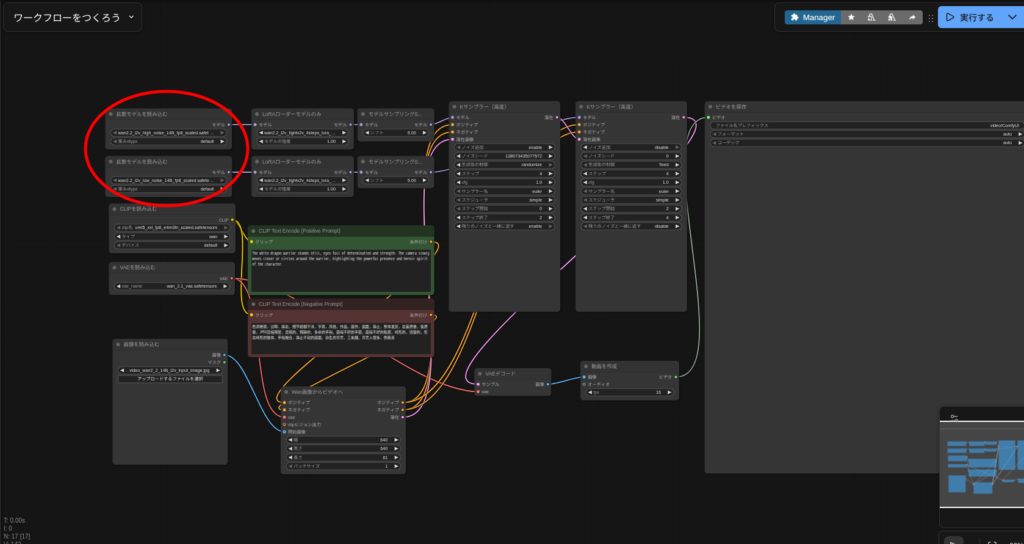

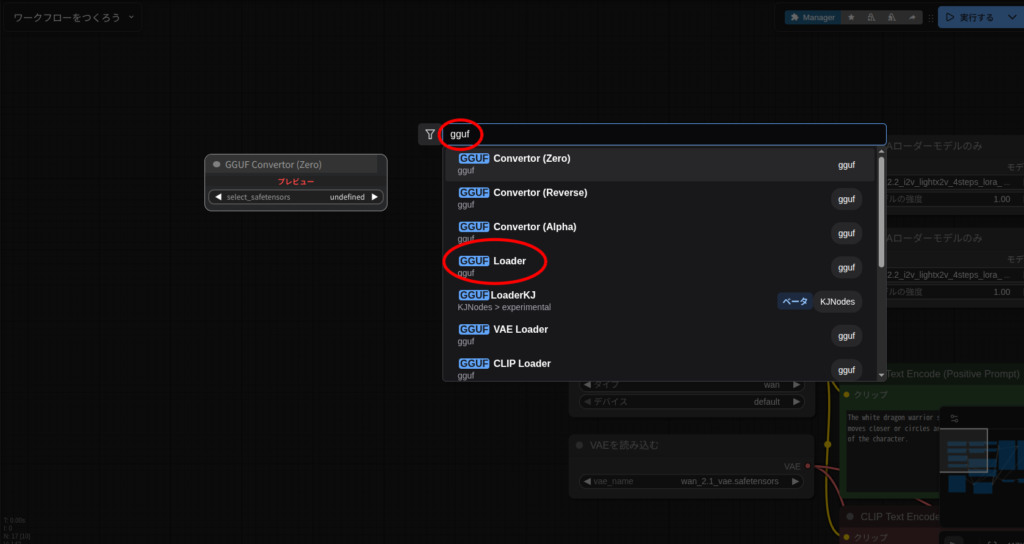

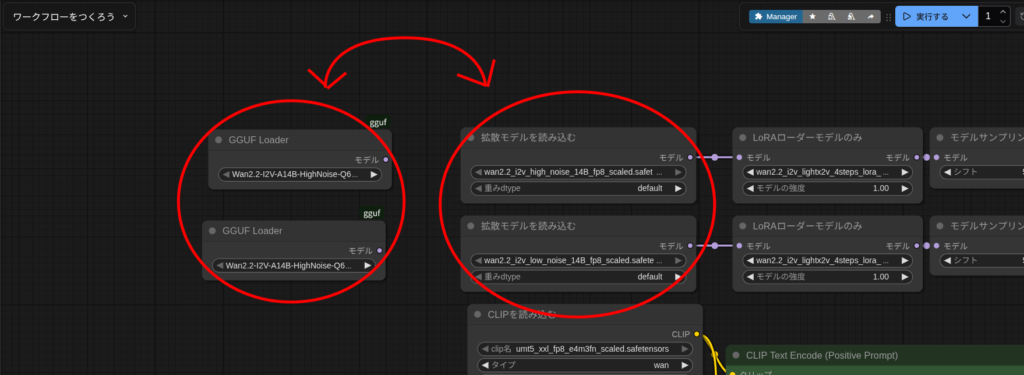

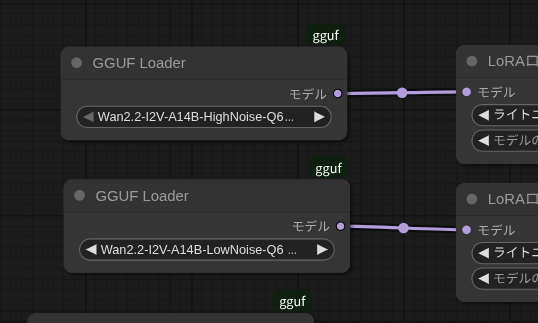

diffusion modelsから

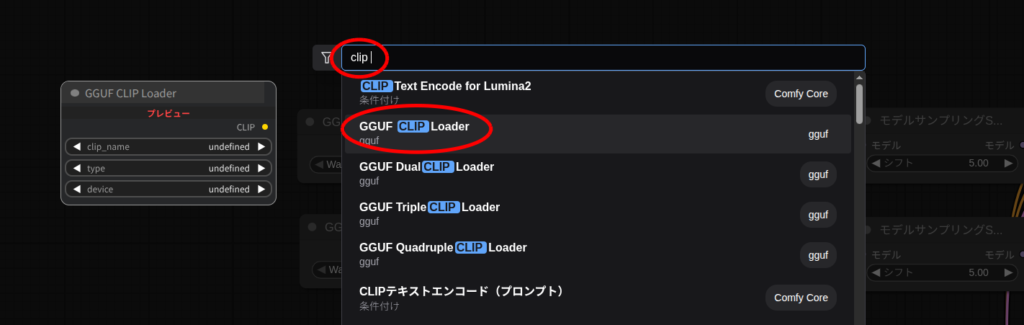

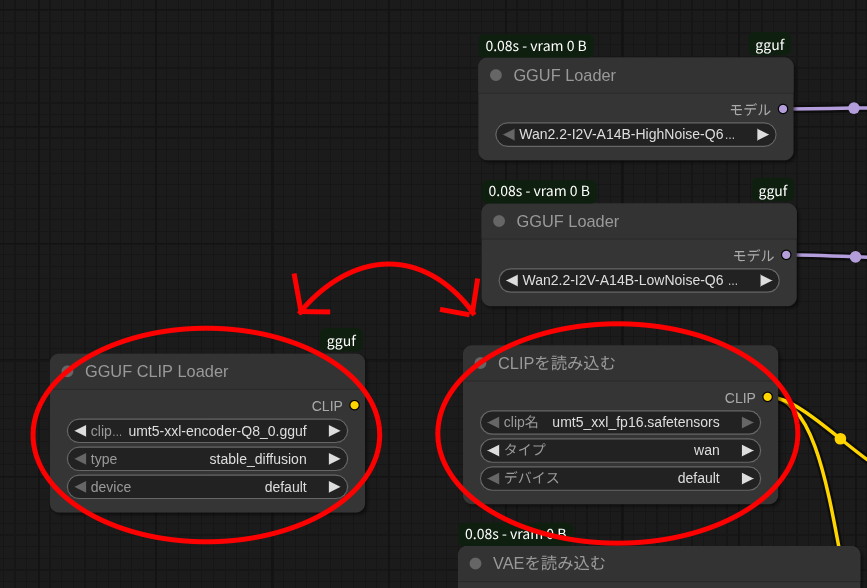

次はテキストエンコーダ

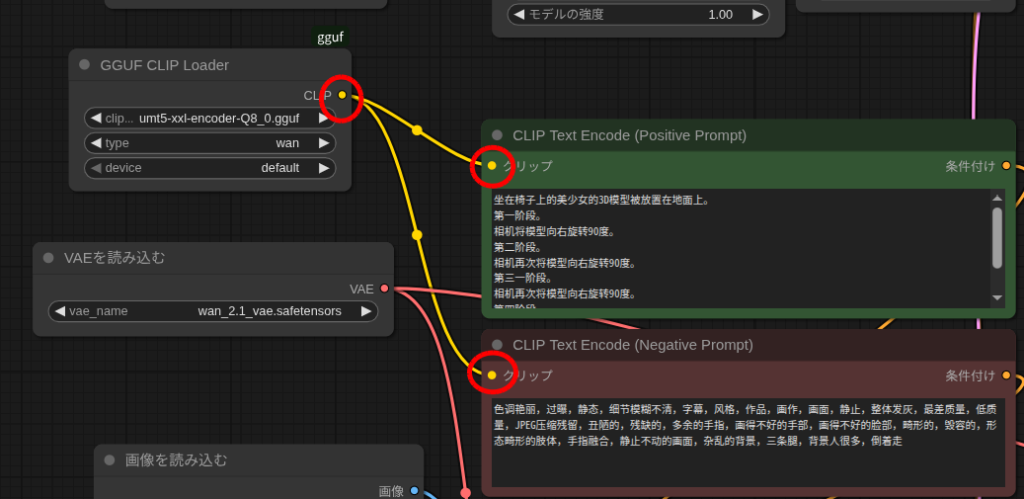

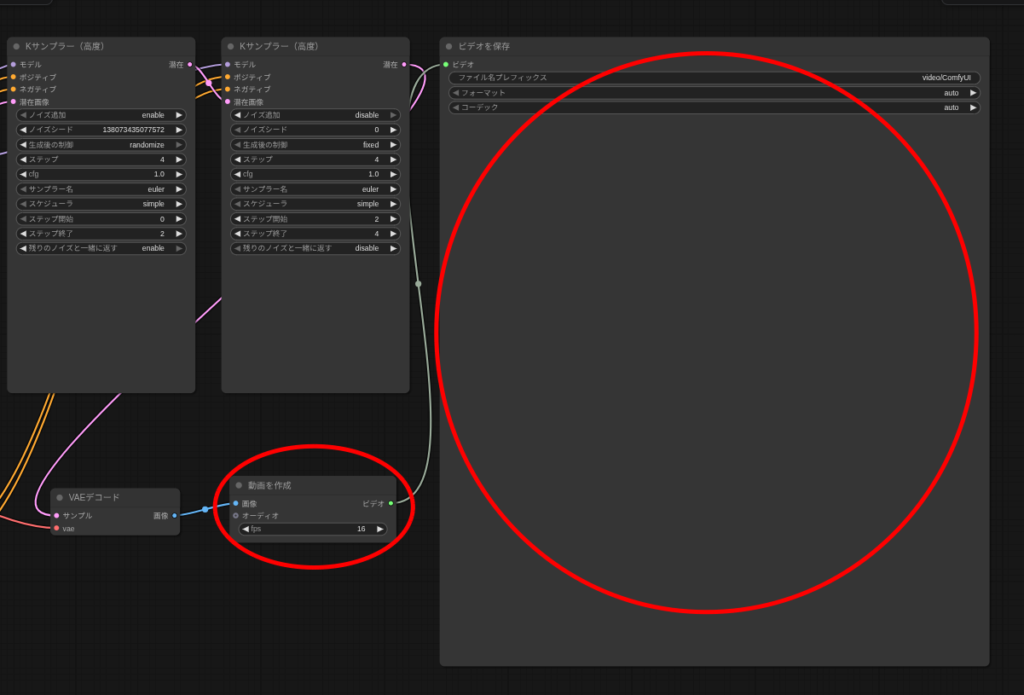

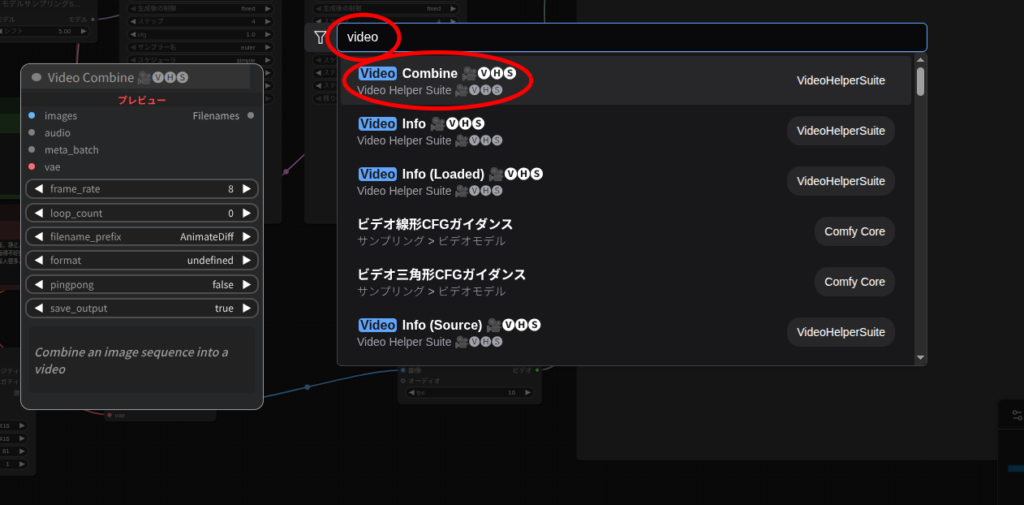

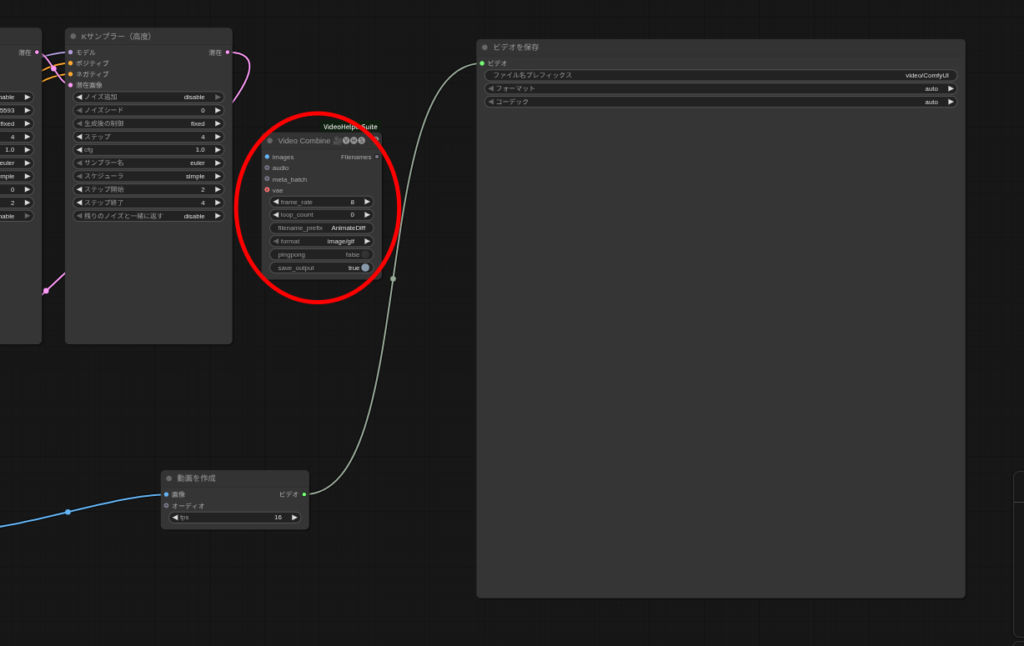

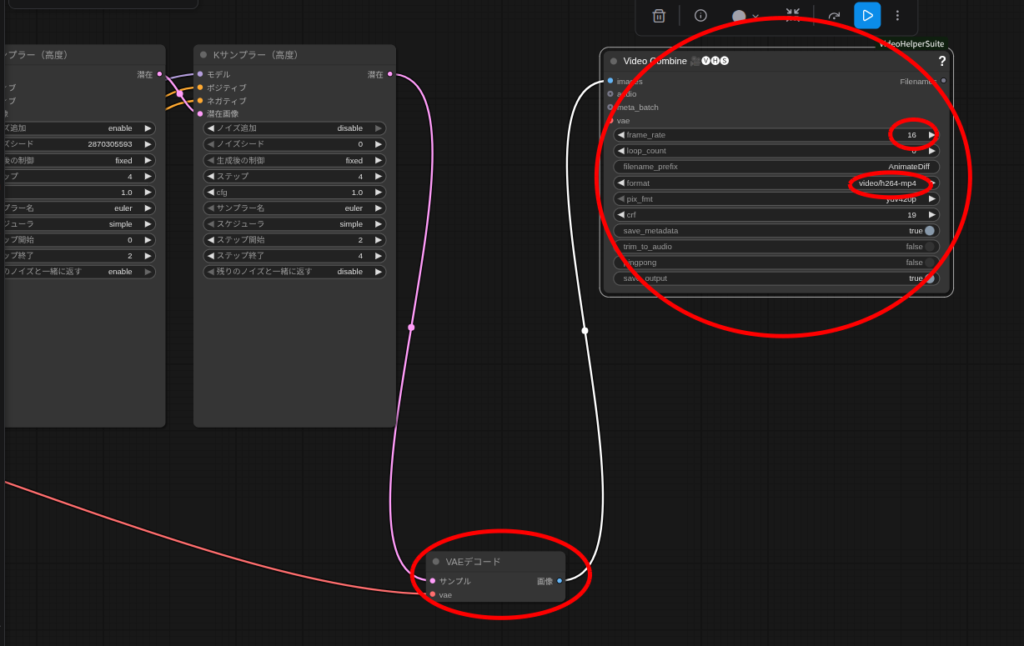

「ビデオを保存」を別のノードへ

これは好みなので別にやらなくてもいいです。

自分はいつも「VideoHelperSuite」の「Video Combine」に変えちゃいます。

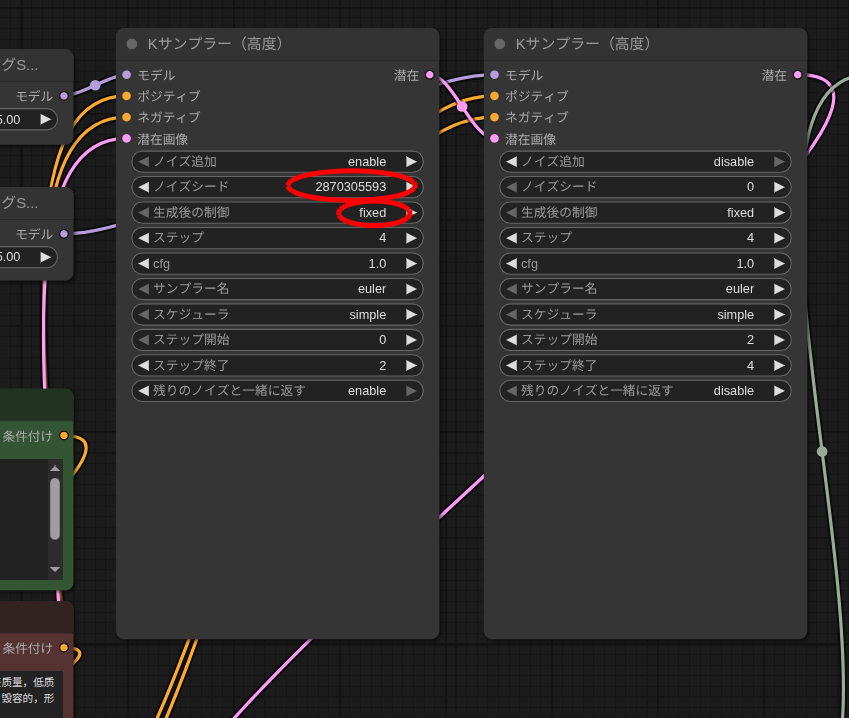

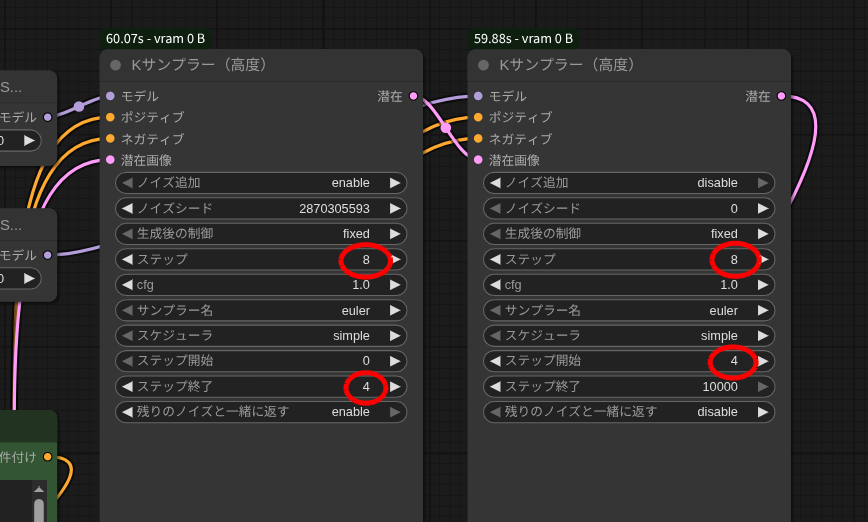

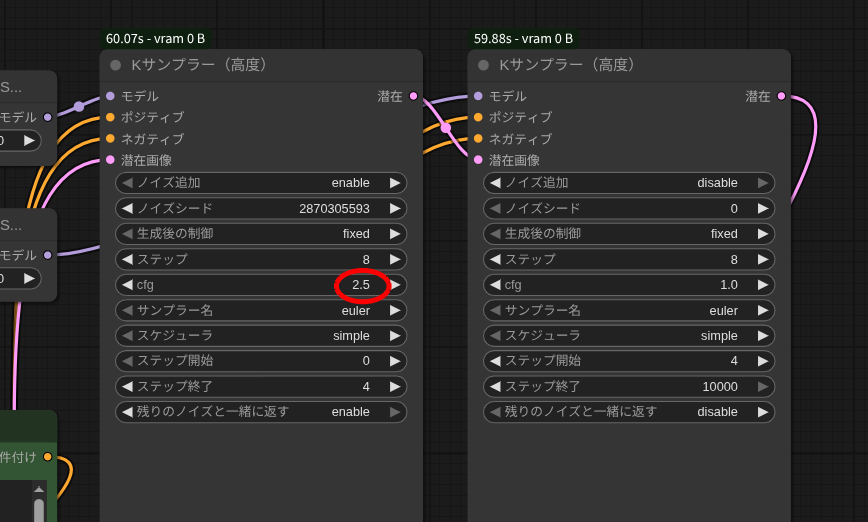

Kサンプラーの設定を変更

これも別にやらなくても良いんですが、今回はちゃんと動くか確認するためにあえてseed値を固定します。

ちゃんと動くことを確認したら、ランダムに戻しておくと良いでしょう。

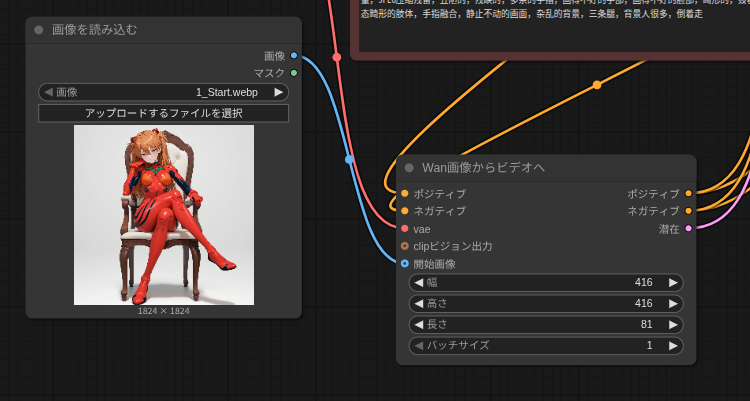

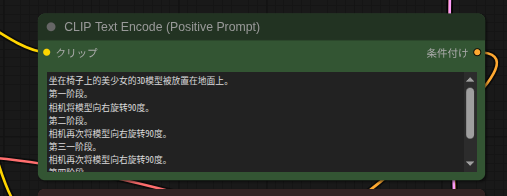

生成条件を設定

坐在椅子上的美少女的3D模型被放置在地面上。

第一阶段。

相机将模型向右旋转90度。

第二阶段。

相机再次将模型向右旋转90度。

第三一阶段。

相机再次将模型向右旋转90度。

第四阶段。

相机再次将模型向右旋转90度。

相机已回到初始位置。それでは生成テスト

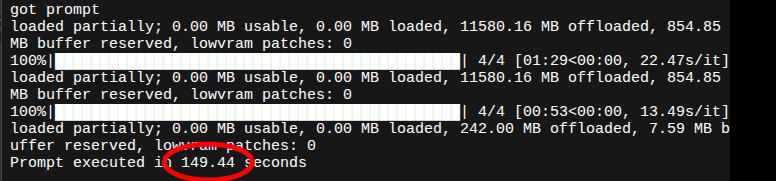

今回のテストでは「Arc Pro B60」を「–novram」で使っていますが、おそらく「Arc B580」や「B570」でも実行できると思います。

では、「実行する」で生成開始。

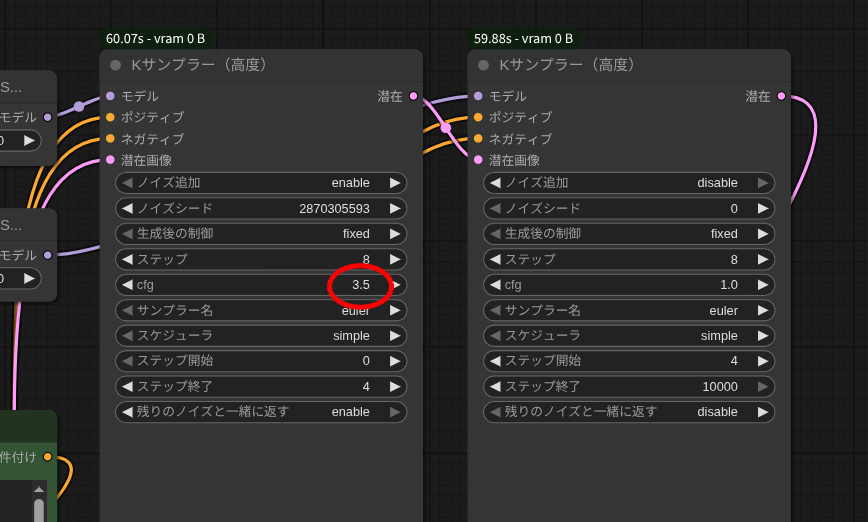

ということで、サンプラーの設定をちょっと変えていきましょう。

ですが、本来は生成される動画の動きをアグレッシブにするため「cfg」の値が「1」ではなく「3.5」です。

本家の出来栄えとくらべると画質が荒いです。

このへんは自分の調整不足ですね。

うまく調整できる人は教えていただけるとうれしいです。

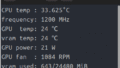

ちなみに生成にかかった時間は、

本家と比べると画質で劣り、生成時間でも劣ります。

ただ、たぶんですがB580でも同タイムが出るのではないでしょうか?

試してませんが・・・。

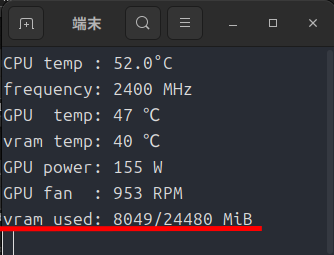

今回のベンチで必要なPCのリソース

ということで、実行できるハードルがかなり下がります。

とはいえ、生成する動画の解像度を上げていくとVRAM消費量もどんどん上がっていきます。

自分のマシンと相談して解像度やフレーム数を調整しましょう。

今回は以上です。

結局コスパ最強は「Arc B580」だと思いました。

「Arc Pro B60」にしようか下のリンクの「Radeon AI Pro R9700」にしようか最後まで悩んだんですが・・・。如何せん値段が。

それでも、再入荷のたびに速攻で売り切れるようですね。

コメント