Amazonのアソシエイトとして、当ブログは適格販売により収入を得ています。

以前この記事で、音声の文字起こしにROCmを使うという記事を書きました。

今回はIntel Arcでwhisperを動かしてみます。

それではいってみましょう。

Intel Arc用whisperの導入スクリプト

#!/bin/bash

sudo apt install -y git

#sudo apt install ffmpeg #自前でビルドした場合はこの行はコメントアウトしてください。

sudo apt install -y python3-venv

cd ~

cd install

git clone https://github.com/openai/whisper.git

cd whisper

mkdir -p material output

python3 -m venv venv

source venv/bin/activate

#nightly

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/nightly/xpu

pip install -U pip setuptools

pip install . 例によって「install」フォルダを作ってその中に「whisper」をインストールしています。

pytorchを導入する部分だけxpu用になっています。

ただ、これだけではCPUにフォールバックされて動作します。

起動オプションに「–device xpu」を付ける

前回の記事どおりに音声ファイルを置くならば、起動コマンドは

time whisper material/test.wav --model medium --output_dir ./output/ --device xpuとなります。

最後に「–device xpu」を付け足すだけです。

RX9060XTと比べると?

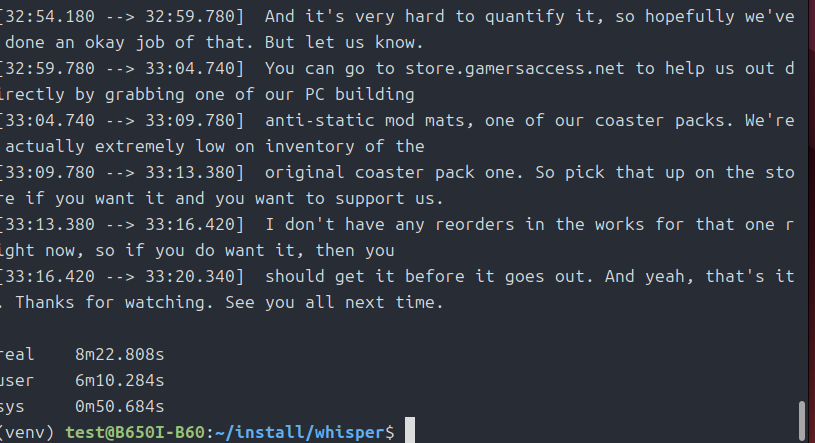

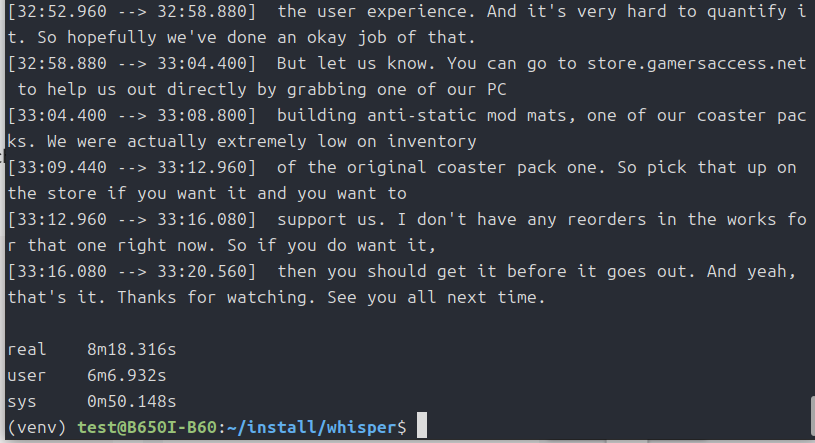

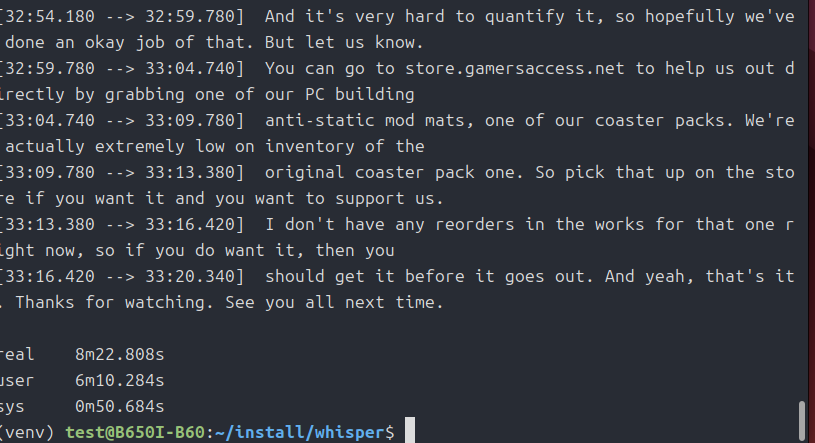

RX9060XTだと10分6秒だったので、Arc Pro B60の方が1分40秒ほど早くなりましたね。

VRAM使用量は7GB未満だったので、B570やB580でも動くと思います。

今回は以上です。

追記

ChatGPTといろいろ相談していると、「Intel Arcならfp16よりbf16の方が適していますよ」みたいに言われたので、実践してみました。

変更方法は、「whisper」フォルダの中にある「transcribe.py」の595行目あたりにある

model = load_model(model_name, device=device, download_root=model_dir)のすぐ下に

model.to(torch.bfloat16)を挿入するだけです。

ただこの変更をしてしまうと、CPUフォールバックで動作させた時も「bf16」になってしまうのでどうしてもCPUで動かしたい時はこの変更はしないでください。

うまく分岐処理をさせれば両方対応できると思いますが、今回はやりません。

結局コスパ最強は「Arc B580」だと思いました。

「Arc Pro B60」にしようか下のリンクの「Radeon AI Pro R9700」にしようか最後まで悩んだんですが・・・。如何せん値段が。

それでも、再入荷のたびに速攻で売り切れるようですね。

コメント