Amazonのアソシエイトとして、当ブログは適格販売により収入を得ています。

恥ずかしながら、いままでComfyUIを動作させるとき

https://pytorch-extension.intel.com/installation?platform=gpu

上記リンクからIPEXで動作させる方法しか知りませんでした。が、この度

# 安定版

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/xpu

# nightly

pip install --pre torch torchvision torchaudio --index-url https://download.pytorch.org/whl/nightly/xpuでpytorchをインストールすればComfyUIが動作するということを初めて知りました。

今回は、

pip install --pre torch torchvision torchaudio --index-url https://download.pytorch.org/whl/nightly/xpuのnightly版の方がバージョン2.9.0と新しかったのでこちらを使っています。

IPEXと何が違うのかなぁと思ってとりあえず試してみたところ

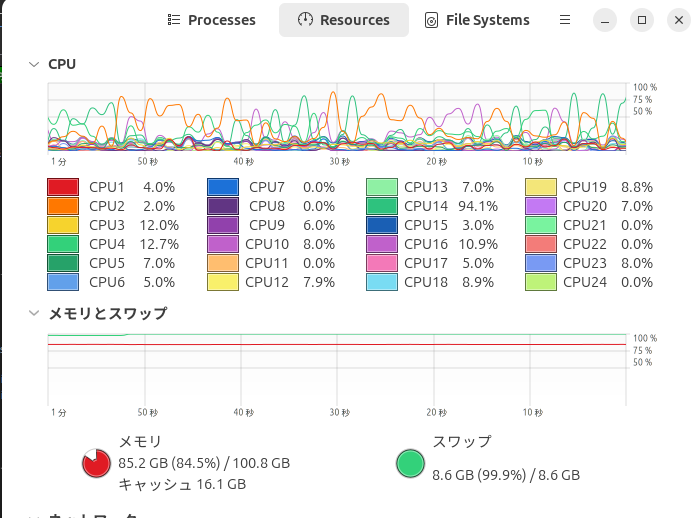

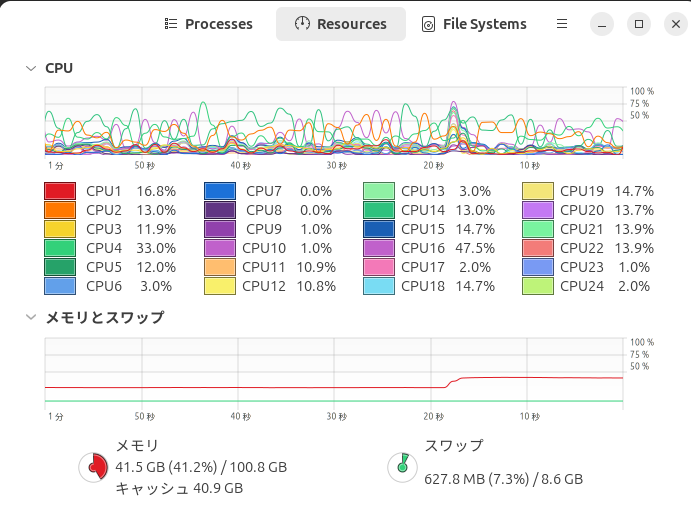

メインメモリの使用量が全然違っていました。

今回は「ComfyUI」+「wan2.2_i2v_high(low)_noise_14B_fp8_scaled.safetensors(14.3GB x2)」+「–novramオプション」+「いつものおねえさん」+「5秒(640×640)の動画生成」でテスト。

GGUF版は相変わらず動作不安定(kサンプラー)なのでsafetensorsを使っています。

キャッシュ使用量が気になりますが、これだけ使用量が少ないなら64GBのシステムメモリでも動作するかもしれません。

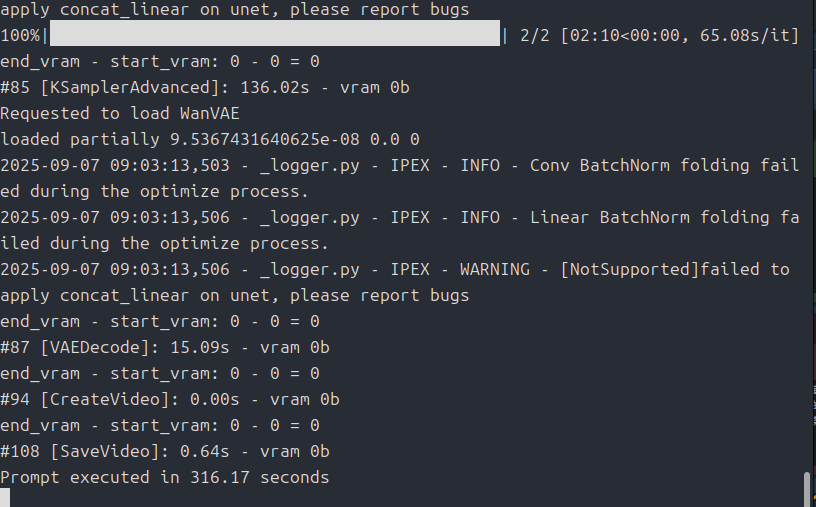

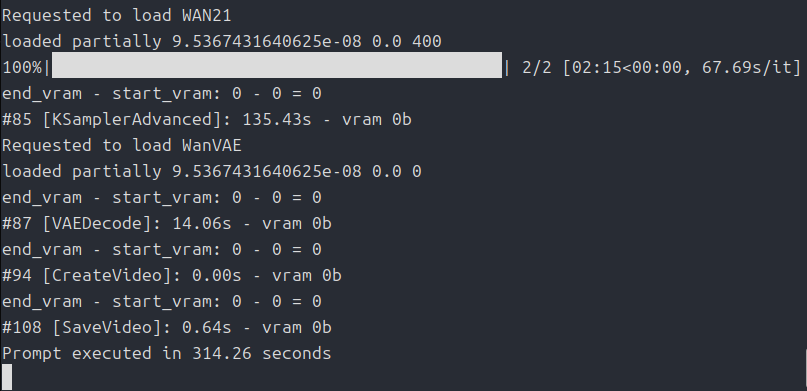

ちなみに同じ条件で生成にかかった時間は

あまり違いはありませんでした。

今回は以上です。

自分が使っているARC B570です。

SPARKLE Intel Arc B570 グラフィックカードOC版 デュアル AXL ファン「GUARDIAN」シリーズ [ B570 GUARDIAN OC 10GB ]

SPARKLE Intel® Arc™ B570 GUARDIAN OC は、10GB GDDR6 メモリと TORN Cooling 2.0 を組み合わせ、デュアル AXL ファン、2.2 スロット設計、フルメタル バックプレートを備えて...

最近はChallengerも安いときがあるようです。

Amazon | ASRock Intel Arc B570 Challenger PCIe 4.0対応 2.6GHz 10GB OC GDDR6搭載 国内正規代理店品 B570 CL 10GO | ASRock | グラフィックボード 通販

ASRock Intel Arc B570 Challenger PCIe 4.0対応 2.6GHz 10GB OC GDDR6搭載 国内正規代理店品 B570 CL 10GOがグラフィックボードストアでいつでもお買い得。当日お急ぎ便対象商...

コメント

当方Windows環境にA750・Pytorch2.8.0+xpu・メインメモリ32GB+仮想メモリ・GGUF版Q4・lowvramで生成してますが、480pくらいならなんとかなってます。

GGUF版についての記事も書かれていますが、何も弄ってない状態でもエラーに遭遇したことはなく、安定して使えています。

原因はよくわかりませんが、おかげで32GBでもなんとかなってます。

コメントありがとうございます!

GGUF版が動いているんですか!?Intel ARCの情報は本当に少ないので、自分で試した限りでしかわからないのです。

ちなみにGGUFはどのカスタムノードをお使いでしょうか?

たぶん、ComfyUI-GGUFだと思うんですが・・・。

あと、どの起動オプションを使っているかも合わせて教えていただけると助かります。

↓の動画の概要欄にある、Googleドライブに置かれている「wan22_14B_gguf_test5.json」のワークフローを使用して生成していますが、GGUFはおそらくComfyUI-GGUFではなく、ggufでしょうか。

https://www.youtube.com/watch?v=Xd6IPbsK9XA

起動オプションはlowvramと、後から付けたbf16-unetくらいです。

(novramでもあまり変わりませんが、画像生成だと極端に遅くなったのでlowvramにしてます)

ちもろぐさんのベンチマーク記事でIntel ARCではうまく生成できていませんでしたが、環境が少し変わるだけでうまくいかなくなることが多々起きている印象です。

原因特定も情報の少なさゆえに難儀することがあって、私も以前から苦労しています。

返信ありがとうございます!

時間をとってテストしてみます!

報告が遅くなってしまいました。

教えて頂いた「wan22_14B_gguf_test5.json」ワークフローを「–novram」で使ってみましたが、やはりKサンプラーで「Native API returns: 39 (UR_RESULT_ERROR_OUT_OF_DEVICE_MEMORY)」が出てしまいますね・・・。

OSはUbuntuです。もしかしたらいまのところ「Intel ARC Aシリーズ」は動作するということなのかもしれません。ちもろぐ氏はVRAMの容量が問題かもしれないと書いていましたが、それだと「A750」で動作している説明がつきませんし・・・。

自分がAシリーズ持っていたら試せるんですが、残念です。

また、時間がとれたらもう少し工夫してみます。

検証お疲れさまです、やはりエラーが出ましたか。

他に思い付く環境の違いはOS、Condaは導入から生成まで未使用、Pythonは3.10.6で行ってるぐらいでしょうか。

自分でもなんでうまくいってるのかよく分からないし、動作報告も画像生成以上に見当たらないのがつらいところです。

時間がとれましたので、再度検証してみました。

結論から言うと、Windows環境にすることでggufの展開は可能になりました。

Ubuntuではまだダメのようです(何故かはわかりませんが・・・)。

torchは「2.10.0.dev20250921+xpu(つまりnightly)」を使っています。

ちもろぐ氏の「1_Wan22_360p_Benchmark.json」ベンチで完走させる場合、

「wan video model loader」の「sageattention」を「SDPA」に、「base_precision」を「bf16」に、「torch.compileノード」をパススルーに、学習モデルを「Q2_K」にする必要があります。

これでも生成中は10GBのVRAMから漏れてメインメモリを1.4GBほど余分に使います(B580ならギリ足りるかもしれません)。

この時の生成時間は530秒ほどでA770のちょい下くらいですね(まぁモデルが違いますが)。